一、研究背景与技术动机

近年来,大型多模态模型(Multimodal Foundation Models)的发展使得 AI 在文本、图像、音频、视频等数字领域具备强大的理解与泛化能力,典型如 Gemini、GPT-4、Claude 3 等。然而,将这种“数字智能”转移到现实世界中的物理智能体(如机器人)仍存在显著鸿沟。机器人必须具备“具身推理能力”(Embodied Reasoning),即理解并操作三维物理空间中的物体关系、力学接触、时序变化等要素,这远比在虚拟环境中回答问题或生成图像复杂得多。

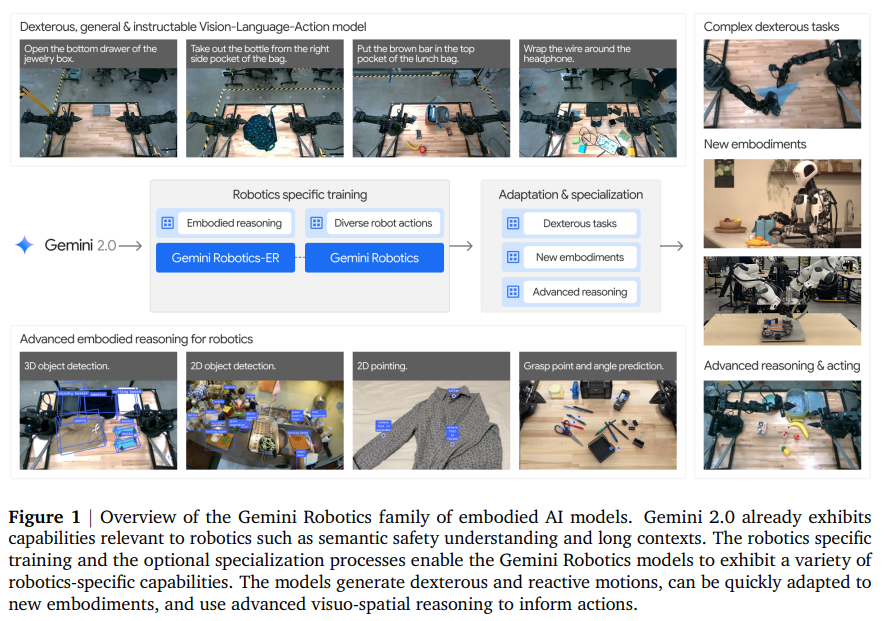

传统机器人系统大多依赖于手工设计的模块(如识别、轨迹规划、控制器等)组合,难以实现大规模泛化。为此,Google DeepMind 提出了 Gemini Robotics 系列模型,试图将 Gemini 2.0 的通用语言与视觉理解能力通过具身推理扩展到机器人控制中,构建出端到端的“视觉-语言-动作”(Vision-Language-Action, VLA)模型,实现通用机器人智能体的目标。

二、模型体系结构概述

Gemini Robotics 模型体系由两个主干模型构成:

- Gemini Robotics-ER(Embodied Reasoning)

此模型在 Gemini 2.0 基础上,重点强化具身推理能力,具备对图像中的对象进行空间定位、抓取点估计、轨迹推理、多视角理解、三维空间感知等能力,构建从语言输入到三维世界语义表征的桥梁。它无需特定机器人动作数据训练即可支持零样本控制与策略生成。 - Gemini Robotics

该模型在 Gemini Robotics-ER 之上,进一步引入了大规模机器人动作数据进行训练,使其能够直接输出机器人低阶控制命令。它具备从图像+语言输入到机器人动作控制的端到端推理能力,支持高频控制(50Hz)、低延迟执行(<250ms),并保留了原始模型的通用语言理解与泛化能力。

整体架构包含:

- 云端部署的 VLA 骨干模型(Backbone)负责多模态感知与动作预测;

- 本地执行的动作解码器(Decoder)负责将预测结果转化为机器人的连续控制命令。

三、ERQA 基准集与具身推理能力评估

为系统评估多模态模型的具身推理能力,团队构建了 Embodied Reasoning Question Answering(ERQA)基准集。该基准集共计400道多选题,涵盖以下能力维度:

- 空间推理(Spatial Reasoning)

- 轨迹理解(Trajectory Reasoning)

- 动作可行性判断(Action Reasoning)

- 状态估计(State Estimation)

- 指点任务(Pointing)

- 多视图一致性(Multi-view Correspondence)

- 任务场景推理(Task Reasoning)

ERQA 与其他现有 VLM 基准(如 RealWorldQA、BLINK)不同,它不仅考察感知能力,还强调是否具备对物理环境的内在理解、三维场景建模与语义联系能力。

在 ERQA 上,Gemini 2.0 Pro Experimental 使用 Chain-of-Thought(CoT) 提示后准确率可达 54.8%,显著超过 GPT-4o 和 Claude-3.5 Sonnet(最高仅为47%),展示出 Gemini 系列在多步逻辑推理和空间感知方面的优势。

四、核心具身能力详解

Gemini 2.0 与 Gemini Robotics-ER 展示了如下具身推理能力细节:

- 2D 物体检测

可基于开放词汇自然语言查询目标对象,并预测其二维边界框。支持“类别”、“属性”、“功能”描述式查询,支持语义复杂问题,如“检测能擦桌子的物体”。 - 2D 指点能力

可以精准指向图像中显式或隐式目标,如“手柄位置”“放置区域”“可抓取区域”。在 Pixmo、Paco-LVIS、Where2Place 等基准上显著超越专用模型 Molmo。 - 2D 轨迹预测

通过串联多个空间点,预测如“从手移动至工具”或“擦拭盘子表面”的路径,为运动规划提供先验输入。 - 抓取点估计

Gemini Robotics-ER 能从图像中估计抓取点(x, y, θ),包括特定位置抓取(如香蕉柄或中心),可直接用作机器人抓取策略。 - 多视角一致性(Multi-view)

给定多张同场景不同角度图像,模型可进行像素点匹配,用于立体视觉、头手视角理解等任务。 - 单图 3D 检测

支持从单幅图像预测三维包围盒(带尺寸、位置、姿态),在 SUN-RGBD 数据集上超越传统三维检测方法(如 ImVoxelNet、Implicit3D)。

这些功能为机器人提供了高层语义、空间结构、三维约束等基础知识,无需传统的三维建图模块即可实现高阶任务理解。

五、零样本与少样本机器人控制

Gemini Robotics-ER 支持两种机器人控制方式:

- 零样本代码生成控制(Zero-shot Code Generation)

通过自然语言指令与环境图像,模型生成调用机器人 API 的代码,包括物体检测、抓取、移动等操作。无需任何机器人动作数据训练即可控制真实或模拟中的 ALOHA 2 双臂机器人完成复杂任务(如“将玩具放入盒子再关闭盒子”)。 - 少样本 In-Context Learning(ICL)

通过将 10 个演示(语言+轨迹)作为上下文提示,模型可直接在推理时模仿行为轨迹。实验显示,在现实任务中,如“擦拭盘子”“折衣服”,使用 ICL 可将成功率从25%提升至65%。

六、通用模型 Gemini Robotics 的能力验证

Gemini Robotics 是进一步微调后的通用机器人控制模型,具备以下特性:

- 高频动作控制(50Hz)、延迟<250ms,支持实时反应;

- 在无需微调的前提下可直接完成多种高难度操控任务;

- 能精确理解复杂语言指令,如“将牙膏放入最底层格子”;

- 在语言模糊、视觉干扰、目标变化场景下保持鲁棒;

- 适配多种任务类型,包括柔性物体操控、变形物体交互等。

在20项现实任务上,Gemini Robotics 平均成功率达80%,显著优于同样训练数据下的 Diffusion Policy 和 Pi-0 模型(仅50%上下),在多个复杂任务中(如“打开文件夹”、“缠绕耳机线”)为唯一成功者。

七、高阶任务特化与极端泛化能力扩展

- 长时序高精度任务特化

在额外 2000~5000 个高质量示范数据上微调后,Gemini Robotics 可完成以下复杂任务:

- 折纸狐狸(需4次精细双臂折叠)

- 做便当(夹面包、装水果、封口等多步骤)

- 玩拼字游戏(从图识别对象并拼出单词)

- 打牌游戏(使用发牌机、握牌、选牌) 这些任务平均成功率高达79%,显著超越 diffusion 和 Pi-0 特化模型。

- 理性泛化增强

通过在机器人数据中注入具身推理中间表示(如空间轨迹、物体状态),实现模型在指令变化、视觉扰动、动作初始状态变化下的泛化能力提升。 - 快速适配新任务

对于新任务(如“午餐盒第一步”“首次折纸”),通过 100 个示例即可达到 >70% 成功率,两项任务达100%,比 Pi-0 更高效。 - 适配新硬件平台

可通过少量微调迁移至 Franka 双臂机器人或 Apptronik Apollo 五指人形机器人,任务成功率 >60%,在新平台上的视觉与动作泛化能力依然优越。

八、安全策略与责任性开发

- 传统安全措施集成

将 Gemini Robotics 作为高层感知与决策模块,底层依旧保留物理约束控制器(如 MPC、力控),保证力域与空间域的安全性。 - 语义安全机制:ASIMOV 数据集与宪法式训练

引入 ASIMOV 安全数据集,包括真实伤害案例问答、图文多模态危险识别。Gemini Robotics-ER 经过微调后能以 96% 准确率识别不安全指令,并在遭遇提示劫持时仍具鲁棒性。 - 内容安全继承自 Gemini 训练规程

包括避免生成仇恨内容、不当医疗建议、个人信息泄露等内容,模型支持对指令进行语义审查与行为修改建议。

九、结论与未来展望

本研究展示了将强大多模态基础模型迁移至机器人领域的完整路径,包括:

- 建立 ERQA 基准衡量具身推理能力;

- 构建 Gemini Robotics-ER 实现高层语义与物理世界的融合;

- 微调为 Gemini Robotics,实现从语言+图像到机器人动作的端到端映射;

- 展示模型在高精度任务、极端泛化、快速学习、新硬件适配等方面的能力;

- 建立系统的安全评估与控制策略,推进通用机器人发展路径。

未来,Gemini Robotics 的方向将包括:提升长期记忆与计划能力、多模态多传感器融合、多机器人协作、跨环境迁移与实时交互建模等,最终实现能胜任真实世界多任务、多变环境、自然语言交互的通用机器人智能体。