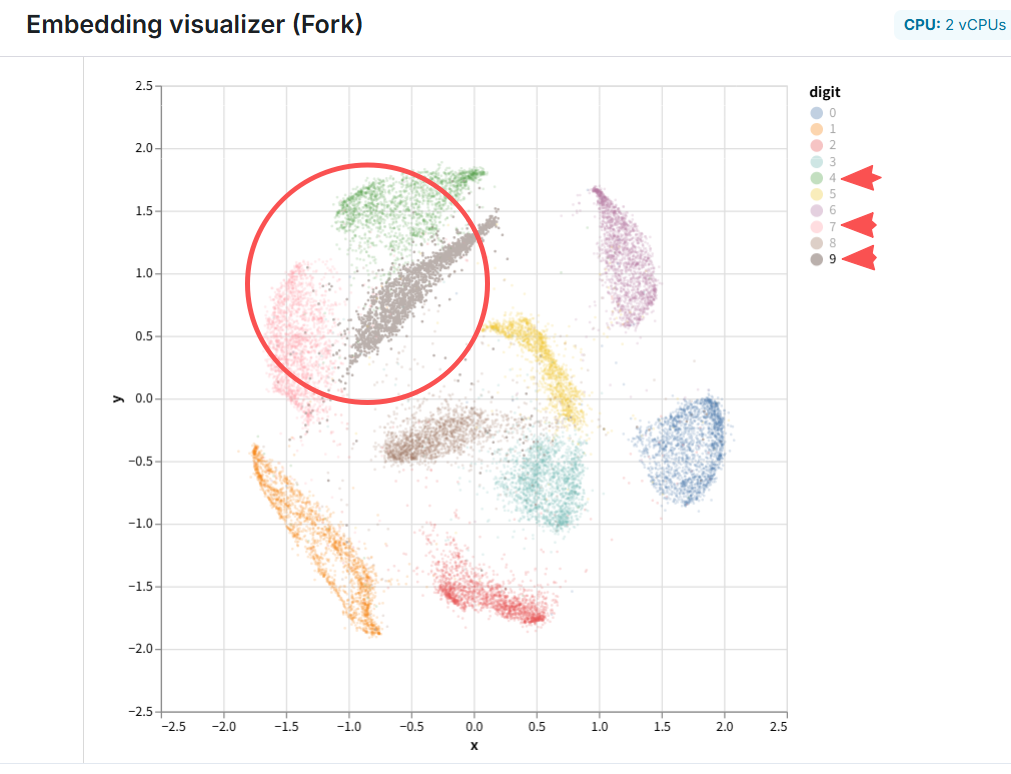

Conformer-PhyFaultNet:滚动轴承故障诊断的泛化尝试

论文 Conformer-PhyFaultNet: Physics-Informed Spectral Att...

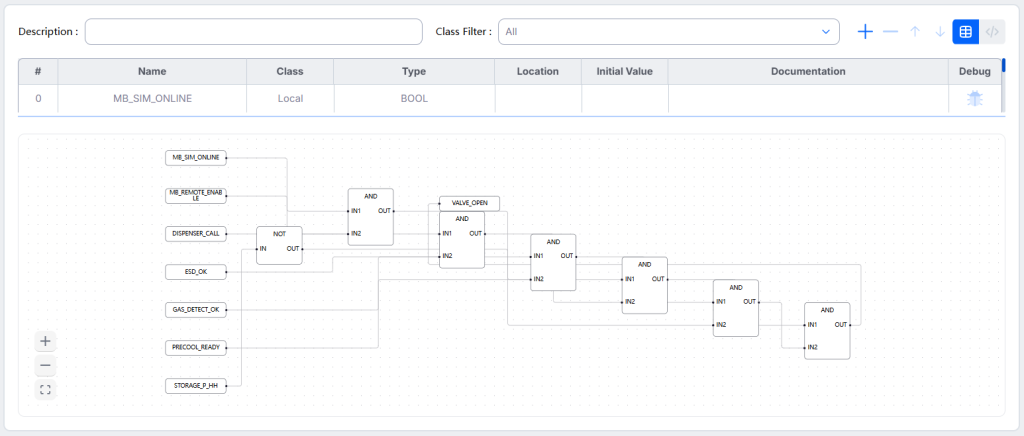

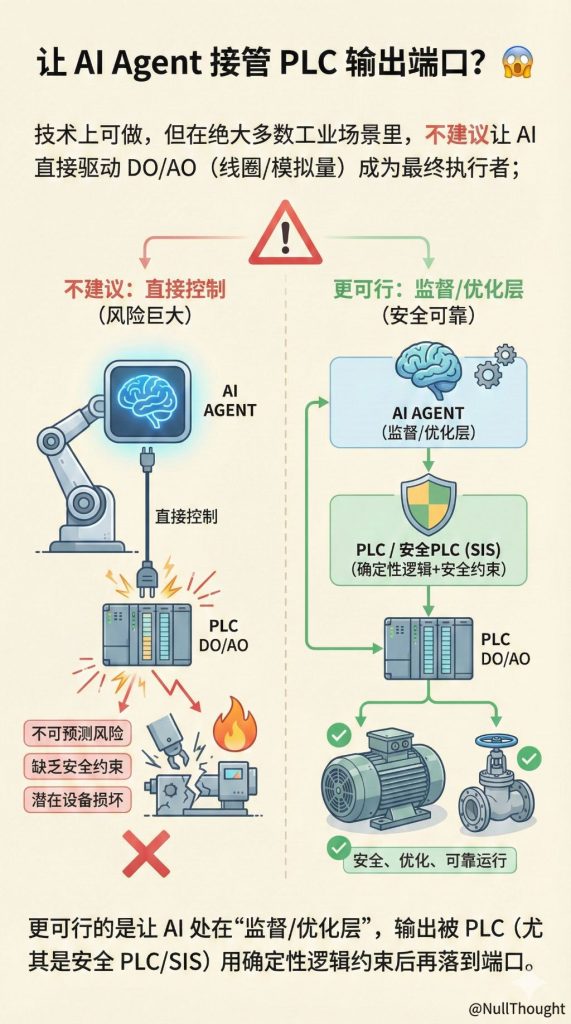

Read More用Codex实现设备控制叙述(Control Narrative)到PLC控制逻辑FBD(Functional Block Diagram,功能块图)

Implementing the conversion from equipment Control Narr...

Read More大模型(LLM)正在如何改变学术研究生态:论文产量激增,但质量信号被“打乱”,同行评审与科研评估体系承压

How AI is transforming research: More papers, less qual...

Read MoreCoreWeave : 专做 GPU/AI 计算 的“新型云(neocloud)/AI hyperscaler”

CoreWeave 是一家专做 GPU/AI 计算 的“新型云(neocloud)/AI hyperscale...

Read More