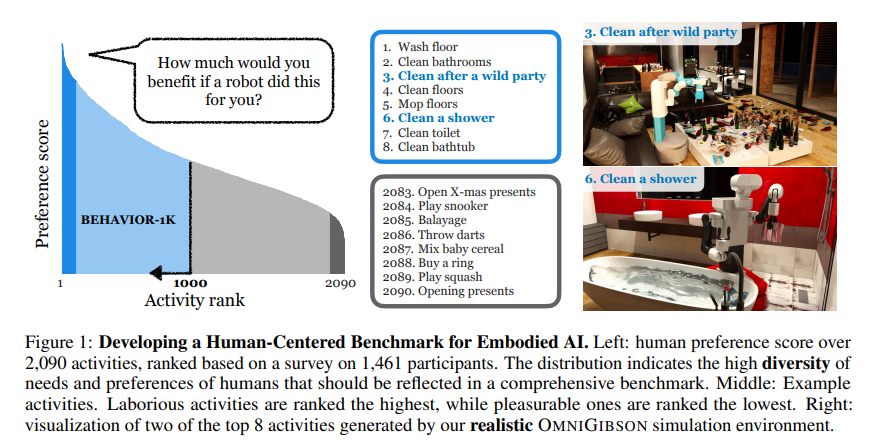

BEHAVIOR-1K 是一个面向“人类真实需求”的具身智能/家用机器人基准:它把 1,000 个日常家庭活动(清洁、烹饪、整理等)形式化为可评测的长时程任务,并提供成套模拟、数据与工具,用来训练与评估移动操作(mobile manipulation)智能体。任务来源于大规模人类时间使用与偏好调查,强调“机器人能帮人做什么”这个维度。官方网站与论文把它定位为“人本”与“现实感”兼顾的综合基准。behavior.stanford.edu+1

Benchmark with 1,000 Everyday Activities and

Realistic Simulation

一、核心组成

- 任务定义(BDDL):用一阶逻辑把每个活动写成「对象范围 + 初始条件 + 目标条件」,并配有谓词/函数解析器与采样/校验接口;1,000 个任务都在 BDDL 中维护,可本地或在线知识库浏览。behavior.stanford.edu+1

- 仿真引擎(OmniGibson):基于 NVIDIA Omniverse / Isaac Sim / PhysX,提供高保真物理与写实渲染,支持刚体、可变形体与液体等效果,并封装机器人控制器、传感器、向量化并行环境等高层 API。behavior.stanford.edu+1

- 3D 资产与知识库:约 50 个可交互场景、≈9k+ 对象(带语义/物理属性),以及粒子系统(如水/污渍等)与“转化规则”(切片、清洗、加热/融化、配方等)。资产多来自 ShapeNet / TurboSquid,因授权要求而加密分发;在线知识库可浏览任务、同义词集(synset)、类别、对象、场景与转化等统计。behavior.stanford.edu+2arXiv+2

- 遥操作与采集:配套 JoyLo/VR 等遥操作接口与示例,用于示教/数据收集与人机在环。behavior.stanford.edu

二、规模与难点

- 规模:1,000 个活动、≈50 个住宅/办公室/餐馆等场景、≈9k 对象;任务跨度长、对复合操控技能与多步骤规划要求高。arXiv+1

- 真实感:支持液体、可变形、热效应、透明/反射、复杂关节等,使“做饭/清洁/收纳”这类操作的前置/后置条件与物理后果可在仿真中真实发生。Proceedings of Machine Learning Research

三、开源工程仓库结构(一体化工程)

官方 GitHub 仓库把主要模块放在同一处,典型目录包括:OmniGibson/(仿真)、bddl/(任务与知识库)、datasets/(场景/对象/粒子系统)、docs/(文档与示例)等,便于“拉仓库→装依赖→跑示例”的完整流程。GitHub

四、快速上手(官方脚本)

- 系统建议:Linux/Windows,推荐 32 GB+ 内存、8 GB+ 显存、RTX 2080 或更高。GitHub

- 一键安装思路:克隆仓库(可用最新稳定版 tag,例如 v3.7.1),执行

setup.sh/setup.ps1并按需加开关:--omnigibson(仿真)--bddl(任务库)--joylo(遥操作)--dataset(下载数据)- 无人值守时可用

--accept-nvidia-eula、--accept-dataset-tos等自动接受协议。GitHub

- 运行与示例:文档内提供环境/学习/对象状态/遥操作等 demo(如

behavior_env_demo、navigation_policy_demo),以及评测接口与基线指引。behavior.stanford.edu

五、评测与竞赛

官网提供 BEHAVIOR 2025 Challenge(赛道、基线、榜单、评测规程与指标),用于统一比较各方法的任务成功率与效率等指标。behavior.stanford.edu+1

六、为什么重要

BEHAVIOR-1K 把“人真正想让机器人做的事”转成标准化、可复现实验——同时覆盖语义前后置条件与细致物理后果,能系统性地推动长时程移动操作、规划与学习(如 RL/IL/语言引导策略)的研究,也支持从仿真到真实机器人的迁移研究。arXiv