在神经网络中,归一化(Normalization) 是一种用于调整和标准化神经元激活值的方法,主要目的是 加速训练、提高稳定性、改善泛化能力。归一化方法最早是在深度学习训练中为了解决梯度消失和梯度爆炸问题提出的,随着研究的深入,其作用已扩展到 优化优化器的行为、提高模型泛化能力,甚至在某些情况下起到了 正则化(Regularization) 的效果。

归一化方法可以根据 归一化的维度 和 应用位置 分为不同类别。以下是对神经网络归一化的详细讲解,包括背景、主要类型、数学原理、作用、挑战及最新研究进展。

一、归一化的背景

为什么需要归一化?

神经网络的训练通常涉及 梯度下降(Gradient Descent),然而,由于深度网络层数多、参数更新复杂,模型训练可能面临以下问题:

- 梯度消失(Vanishing Gradient):

- 反向传播时,梯度在深层网络中逐渐变小,导致模型训练缓慢,甚至无法学习到有效表示。

- 主要发生在使用 Sigmoid 或 Tanh 激活函数的情况下,因为这些函数的导数在极端值处接近零。

- 梯度爆炸(Exploding Gradient):

- 反向传播时,梯度在深层网络中不断累积,使得参数更新过大,导致训练不稳定。

- 主要发生在 权重初始化不当、学习率过高 的情况下。

- 内部协变量偏移(Internal Covariate Shift):

- 随着训练进行,每层的输入分布会不断变化,导致网络学习变得困难,需要不断调整学习率和超参数。

- 不同层的学习速率不一致:

- 由于输入分布的变化,深层网络的不同层可能需要不同的学习率,否则容易出现学习不稳定或过拟合。

归一化技术的引入,尤其是 批归一化(Batch Normalization, BN),成功缓解了上述问题,使得深度网络训练更加稳定、高效,并促进了 更深层网络的成功训练。

二、归一化的主要类型

归一化的方法可以按照 归一化的维度 进行分类,如下所示:

| 归一化方法 | 归一化维度 | 适用场景 | 代表性论文 |

|---|---|---|---|

| 批归一化(Batch Normalization, BN) | 批次维度 (B) | CNN, Transformer, GAN | Ioffe & Szegedy, 2015 |

| 层归一化(Layer Normalization, LN) | 特征维度 (C) | Transformer, NLP | Ba et al., 2016 |

| 组归一化(Group Normalization, GN) | 分组特征 (G) | 目标检测, 语义分割 | Wu & He, 2018 |

| 实例归一化(Instance Normalization, IN) | 空间维度 (H, W) | 风格迁移, GAN | Ulyanov et al., 2016 |

| RMS归一化(RMSNorm) | 仅标准差 | LLM, NLP | Zhang & Sennrich, 2019 |

| 权重归一化(Weight Normalization) | 归一化权重 | 强化学习, 生成模型 | Salimans & Kingma, 2016 |

三、三种主要归一化方法的数学原理

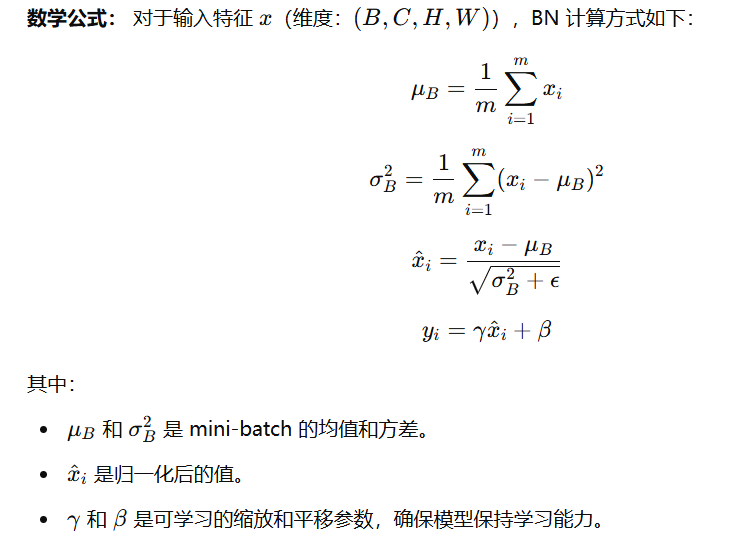

1. 批归一化(Batch Normalization, BN)

批归一化 是最早提出并广泛应用的归一化方法,它的核心思想是:

- 对每个批次(Batch)的输入特征进行归一化

- 降低内部协变量偏移

- 使不同 mini-batch 的数据分布更稳定

BN 具有 加速训练、提高稳定性 的作用,但在 小批量(small batch) 场景下效果不佳,例如目标检测、语义分割等任务。

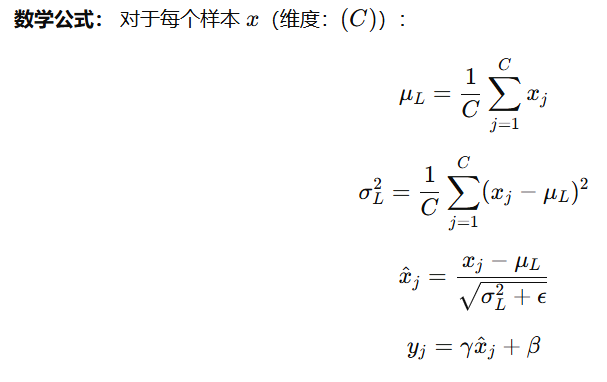

2. 层归一化(Layer Normalization, LN)

层归一化 是 BN 的变种,主要用于 序列建模(Transformer, LSTM),其核心思想是:

- 对每个样本的所有特征维度归一化

- 适用于变长输入(如 NLP)

- 独立于 batch size,适用于小批量训练

LN 不依赖 batch size,在 NLP 和自注意力机制中广泛应用,例如 Transformer。

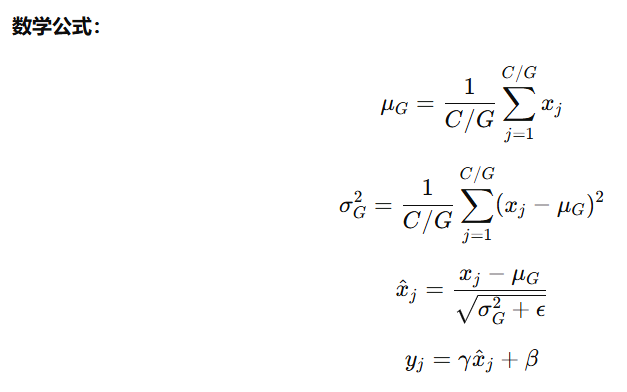

3. 组归一化(Group Normalization, GN)

组归一化 解决了 BN 在小批量任务上的问题:

- 将通道分成 G 组,在组内进行归一化

- 适用于计算机视觉任务

- 在小 batch 训练时更稳定

四、归一化的作用

- 加速训练,提高收敛速度

- 稳定梯度,减少梯度爆炸

- 减少内部协变量偏移

- 提升泛化能力,防止过拟合

五、归一化的挑战

- BN 依赖 batch size,在小 batch 任务中效果不稳定

- LN 对计算资源要求高

- 某些任务(如风格迁移)可能不适合某些归一化方法

六、最新研究进展

- Transformers without Normalization(DyT):使用 tanh(αx) 替代归一化,提高计算效率。

- Adaptive Normalization:动态调整归一化策略,提高适应性。