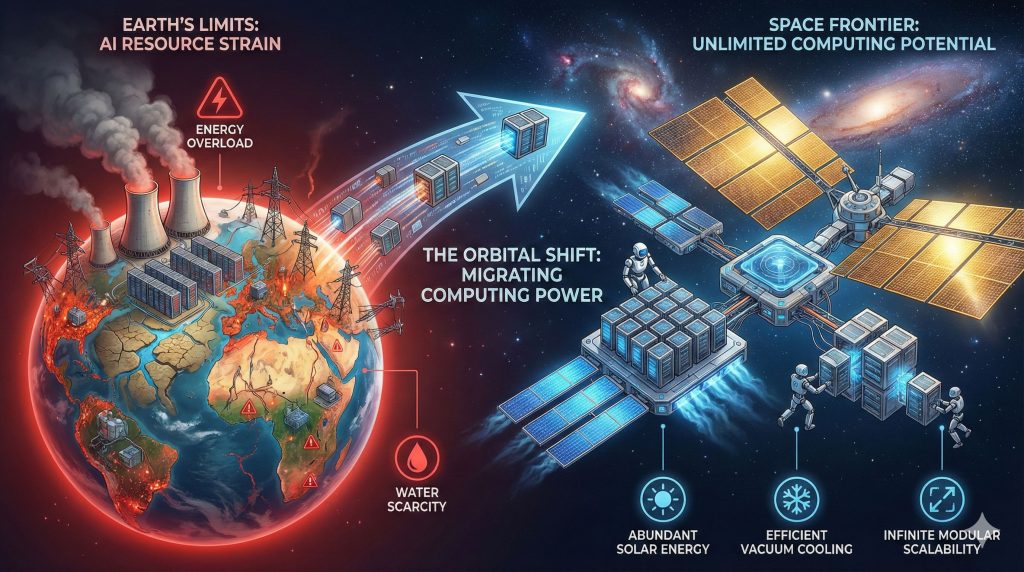

Google 最新论文Towards a future space-based, highly scalable AI infrastructure system design立足于一个判断:如果把 AI 视作电力或蒸汽机那样的“通用目的技术”,那么未来算力与用能需求将持续增长,即便单次查询等环节的能效已显著提升,这一趋势仍难逆转。作者因此从“面向未来、回溯当下”的角度出发,思考如何高效获取并利用太阳系中最充沛的能源——太阳能。空间太阳能相较地面具有几乎连续受光、年累积辐照量可达中纬地面 8 倍等优势,但传统“把能量再传回地面”的路线长期受限于回传链路难题。论文提出改换思路:不把能量送回地球,而是把“计算”送上太空,在轨直接进行机器学习计算。

论文作者为Blaise Agüera y Arcas, Travis Beals, Maria Biggs, Jessica V. Bloom, Thomas Fischbacher , Konstantin Gromov, Urs Köster, Rishiraj Pravahan , James Manyika,来自Google。

一、系统总体设想

面向“多数 AI 计算在太空进行”的远景,作者提出一个中期可验证的里程碑:做出性能大致可与地面数据中心比肩的空间 ML 系统原型。系统以多颗太阳能供电卫星为基础,每星搭载 Google TPU 加速器,通过近距离自由空间光(FSO)星间链路组成低时延高带宽的“在轨数据中心”。轨道选用拂晓—黄昏(dawn-dusk)太阳同步 LEO,以最大化供能;原型阶段地面回传可先用射频避免穿大气的光学复杂性;散热通过热管与辐射器维持名义温度。为在近距离保持编队与防碰,计划采用 ML 控制模型。

二、关键技术挑战与研究范围

论文聚焦四项“卡脖子”指标:① 星间链路的“芯片—芯片级”聚合带宽;② 大规模、超近距编队的动力学与控制;③ TPU 在辐照环境下的可用性;④ 发射成本在中长期的可达水平。同时对在轨可靠性/维修、高带宽地面光链路、热控等给出初步讨论与路线。

三、结果一:星间光链路(ISL)可达 10 Tbps 级

1)需求刻画:地面 TPU 超级计算机采用“两层网络”——数据中心网络提供“pod 级”连接,自研光学 ICI 为单芯片提供数百 Gbps 的低时延互联;而商用 OISL 仅 1–100 Gbps,量级差距巨大。

2)方案要点:使用 COTS 的 DWDM 光模块,关键在于这些器件要求“百微瓦级”受光功率,高于传统长距 OISL 的微瓦级。受光功率在超越菲涅耳极限后近似按 1/d² 衰减,因此把卫星距离“拉近到百千米乃至更短”即可闭合链路预算,达到单链路约 10 Tbps 的聚合带宽。

3)进一步扩展:当距离很短(如 10 cm 口径在约 10 km 内),光斑显著变小,可在同一总口径上布置多路独立小口径阵列,实施“空间复用”(2×2、4×4 乃至 8×8),带宽随并行链路数继续近似按 1/d 反比扩展。这一思想类比地面多空间通道的光电交换实践。

4)台架实证:用现成器件实现了 800 Gbps 单向(1.6 Tbps 双向)的短程自由空间传输,验证了可行性。

四、结果二:大规模近距编队的轨道动力学

作者以“半径 1 km、81 星共面方格阵”为例:满足“近邻稳定、低时延、高受光与链路几何约束”。在地球 J2 摄动作用下,中心星与 8 个最近邻的相对距离在一个轨道周期内于约 100–200 m 之间振荡;整个队形每轨发生两次形状循环,但群体运动可保持在 R 尺度内有界。若不希望严格共面,可叠加出平面振荡以兼顾被动安全与链路几何。给定最小星间距时,星数随集群半径近似二次扩展(N∼R²)。

五、结果三:TPU 辐照测试与在轨可靠性启示

选用 V6e Trillium Cloud TPU 与配套 AMD 主机,在 67 MeV 质子束下模拟拂晓—黄昏 SSO 的辐照环境。估算在 10 mm 铝等效屏蔽下年剂量约 150 rad(Si),5 年寿命需承受约 750 rad(Si) 的 TID,同时还要面对单粒子效应(SEE)导致的瞬态故障与潜在的“静默数据错误”(SDC)。

测试显示:HBM 子系统对 TID 最敏感,约 2 krad(Si) 开始在专用压力测试中出现异常;而端到端 ML 与计算型测试在单片累计 15 krad(Si) 以内未见因 TID 导致的硬失效。HBM 对 SEE 也最敏感,主要表现为不可纠正 ECC(UECC);按观测统计与在轨年剂量估算,推算典型推理作业的失败概率量级约 1/一千万次推理,推理可接受,但对训练作业的影响与系统级缓解策略仍需研究。主机 CPU/RAM 的 SEFI(如系统崩溃)率分别约 1/450 与 1/400 rad(Si)。

六、结果四:发射成本的学习曲线与工程测算

作者用两条互证路径评估“到 2030 年代中期客户价 ≤200 美元/千克”的可达性:(a)基于 SpaceX 公共历史数据的学习曲线法:从早期 ≥3 万美元/千克降至 Falcon Heavy 约 1800 美元/千克,累计 <100 次成功发射、约 400 吨在轨质量,对应 18–24% 的学习率区间;若维持类似学习率并引入更大型可复用运载,则存在继续下探空间。(b)基于 Starship 复用目标与结构参数的自下而上成本法:不考虑燃料降本,仅靠部件 100× 复用,项目方内部成本测算可从约 460 美元/千克降至 ≲15 美元/千克;敏感性分析把整备成本提到 15% 时,100× 复用成本约 38 美元/千克,长期地板由推进剂成本(约 8 美元/千克)决定。对应客户价 200 美元/千克的学习曲线情景下,需新增约 37 万吨累计在轨质量,等效 ~1800 次 Starship 发射、年均 ~180 次,虽雄心勃勃但低于公开的更高发射节拍目标。

七、编队控制与方法学要点

为了把“近距大编队”维持在良好几何与燃料开销内,作者提出基于反向传播的最优控制思路:以轨道动力学 ODE 数值积分构建目标函数,利用伴随态方法与自动微分(如 JAX 框架)对控制律参数反向传播梯度,实现可学习的编队控制器;建模中需尽可能纳入可预报与噪声加速度源,否则会转化为额外的 Δv 需求。

八、优势与工程权衡

空间 ML 数据中心的最大优势在于能源与可扩展性:拂晓—黄昏 SSO 能源几乎连续、地面资源(用地、用水)占用极小;同时高密度近距编队与空间复用 OISL 使“在轨横向扩展”具备工程可行路径。权衡在于:拂晓—黄昏轨道会抬高到部分地面站的时延;在轨光下行对大气扰动敏感、原型期宜先用射频;近距编队的安全冗余、避碰策略与在轨维修更复杂。

九、未决问题与后续路线

作者坦陈仍有若干重大工程问题需进一步验证:在轨可靠性与修复机制、地面高带宽光链路、热控设计裕量、星间/对地链路的长期稳定与对准、碎片与被动安全策略等,计划通过进一步的分析、地面测试与原位原型任务逐步去风险。

十、评价与启示

这项工作把“在轨算力”从科幻拉回到工程分解:把 AI 训练/推理的关键约束(能源、带宽、延迟、可靠性、成本)逐一对应到可量化的空间系统指标上,并给出“近距高复用光链路 + 可学习编队控制 + 中长期发射降本”的闭环路径。它并非完整的经济可行性研究,但通过链路预算、动力学仿真、辐照实测与成本量纲估算,展示了“把数据中心搬到太空”的一条技术可行路线。下一步的成败,取决于三点:其一,星间 10 Tbps 级链路在真实编队几何、指向/热漂与姿控耦合下的长期稳定性;其二,训练作业场景下的 SEE/SDC 全栈缓解(含 HBM 级别到作业编排级别的多层防护);其三,发射—在轨运营—更换—退役的全生命周期成本模型能否与地面算力在“同一张表”上比较并显示结构性优势。总体而言,论文把“空间-规模化 AI 基础设施”从理念推到了“工程假设—实验验证—系统集成”的起跑线上,具备继续推进“原位原型任务”的技术成熟度基础。