论文《That Chip Has Sailed: A Critique of Unfounded Skepticism Around AI for Chip Design》由Anna Goldie、Azalia Mirhoseini和Jeff Dean等人撰写,旨在针对一些对AlphaChip项目的质疑进行详细的反驳和澄清。AlphaChip是一种基于深度强化学习(Deep Reinforcement Learning, DRL)的芯片布局工具,其设计成果已经被广泛应用于多个芯片项目中,包括Google的TPU、数据中心CPU等。

此论文以严谨而详实的反驳回应了针对AlphaChip的不实质疑,强调了在科学研究中遵循标准实验方法和透明实践的重要性。作者通过一系列实验和事实证据,展示了AlphaChip在芯片设计中的巨大潜力和已取得的实际成果,表明AI在硬件设计中的应用已不仅限于理论阶段,而是具备了实际的工业应用价值。

1. 论文背景与AlphaChip的贡献

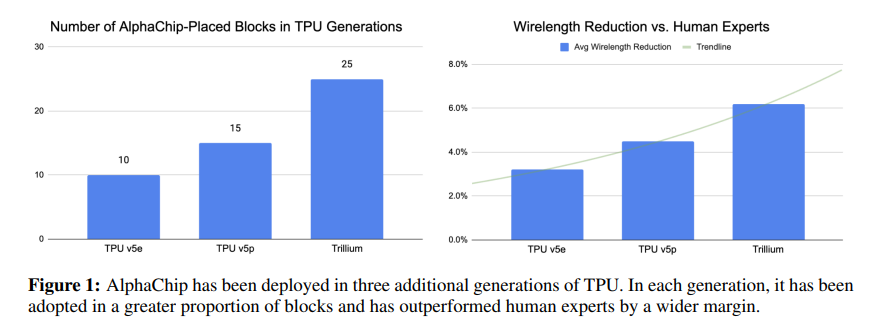

在2020年,AlphaChip首次被提出并发表在《Nature》期刊上,提出了一种基于深度强化学习的芯片布局自动化方法。该方法能够自动生成“超越人类水平”的芯片布局,其影响力使得AI在芯片设计中的应用得到了广泛关注,激发了学术界和产业界的进一步探索和创新。自推出以来,AlphaChip已经成功应用于三代TPU芯片的布局中,并在多个实际部署中显现了优于人类专家设计的表现。

AlphaChip的主要特性

- 基于强化学习的自动化布局:通过深度强化学习技术,AlphaChip能够在芯片设计中不断学习和改进布局策略,具备显著的泛化能力。

- 性能超越人类专家:在多个测试中,AlphaChip生成的布局在功耗、面积利用率、延迟等方面均优于人类专家设计。

- 已被广泛部署:AlphaChip在TPU v5e、TPU v5p等多代硬件中得到了实际应用,这些硬件被广泛用于Google的数据中心以及其他计算需求。

2. 针对质疑的全面反驳

论文主要针对近期在《Communications of the ACM》以及ISPD 2023会议上发表的对AlphaChip的批评进行了逐点反驳,尤其针对Cheng等人和Igor Markov的质疑,作者对这些质疑的实验方法、结论的科学性、以及他们的方法复现过程中的关键错误进行了详尽的分析。

2.1 Cheng等人的质疑及其问题

Cheng等人在ISPD 2023的论文中对AlphaChip的性能提出了质疑,认为其在某些测试中表现不如期望,但作者指出这篇论文中存在以下重大问题:

- 未进行预训练:

- AlphaChip的强化学习模型通过对多个芯片模块的预训练,积累了经验并实现了性能提升。预训练能够使得模型对新任务的适应性更强,从而提高新芯片模块的布局质量。

- Cheng等人没有进行任何预训练,直接让模型从零开始学习,这使得他们的实验失去了AlphaChip的核心优势。正如论文中所说,这相当于让AlphaGo在从未见过围棋的情况下与职业棋手对战,显然会导致不合理的结论。

- 计算资源的不足:

- Nature论文中描述了实验的标准环境,包括使用了512个强化学习经验收集器和16块GPU来训练模型。然而,Cheng等人在其实验中使用了仅26个经验收集器和8块GPU,相比之下计算资源减少了一个数量级。

- 论文中进一步强调,计算资源的减少不仅会显著延长模型的训练时间,还会直接影响模型的最终性能,使得他们的结果不能真实反映AlphaChip的能力。

- 未训练到收敛:

- 在机器学习中,训练到收敛是非常重要的标准步骤,以确保模型能够充分学习任务中的模式。然而,Cheng等人在多次实验中均未能训练到模型收敛,这不仅违反了标准的机器学习实践,也直接导致了性能的欠佳。

- Cheng等人提供的TensorBoard显示,在多次实验中,模型的损失函数在训练过程中都没有达到平稳状态,进一步表明其训练并不充分。

- 测试用例选择不具代表性:

- Cheng等人选择了较为陈旧的45nm和12nm技术节点进行测试,而AlphaChip在Nature论文中的测试环境是亚7nm的现代芯片节点。

- 这种差异使得测试用例在布局密度、布线拥堵等方面与现代芯片有着显著不同,无法有效比较不同布局方法的性能。

- 大规模重实现可能引入新的错误:

- Cheng等人对AlphaChip的方法进行了所谓的“大规模重实现”,而这种过程本身就可能引入额外的实现错误。论文指出,他们提供的代码库和重实现版本并没有经过严格的验证,因此其结果的可靠性存疑。

2.2 Igor Markov的质疑及其回应

Igor Markov在《Communications of the ACM》中发表了一篇“元分析”论文,质疑AlphaChip的科学性和实验结果。作者对Markov的质疑进行了严厉批驳,指出他的分析存在以下问题:

- 缺乏独立实验数据支持:

- Markov的论文没有进行新的实验,所有的分析都基于对AlphaChip和Cheng等人文章的“再分析”。但正如上文所述,Cheng等人的实验本身存在严重的实验设计缺陷。

- 利益冲突和不当陈述:

- Markov在其论文中引用了自己参与撰写的一篇未署名的PDF文档,并未在论文中披露其是共同作者的身份。这种行为违反了学术透明原则,并可能存在利益冲突。此外,Markov在多个平台上进行讨论时曾承认其作者身份,但随后删除了相关声明。

- 关于谷歌内部审查的错误引用:

- Markov提到谷歌内部曾有“举报者”怀疑AlphaChip研究的真实性,但该举报者在调查中明确表示“没有证据支持其怀疑”。Nature也对Markov的质疑进行了复审,并发布了附录支持AlphaChip研究的可靠性,指出没有任何实质性的研究不当行为。

3. AlphaChip的部署和实际应用

AlphaChip的实际应用是其有效性的重要证明。在论文中,作者详细列出了AlphaChip的部署时间线:

- 2020年4月:AlphaChip的初步版本作为预印本发布在arXiv上。

- 2020年8月:AlphaChip的设计被用于TPU v5e的10个模块中。

- 2021年6月:《Nature》正式发表了AlphaChip的研究。

- 2022年1月至7月:在确保符合出口管制规定的前提下,AlphaChip的开源代码经过改进并被发布,代码中剔除了与谷歌内部系统的依赖,使其能够独立复现研究结果。

- 2024年4月:Nature完成对AlphaChip研究的复审,并发布了支持其结果的附录,确认AlphaChip的研究结论无误。

这些时间节点展现了AlphaChip自发布以来的实际应用进展,进一步证明了该技术的有效性和影响力。

4. 透明性与复现性

为了回应外界关于复现性的质疑,作者强调了AlphaChip研究的透明性。论文中指出,他们已经开源了完整的代码库,使得研究社区可以随时对其方法进行验证和扩展。AlphaChip的所有代码,包括强化学习部分和其他必要的预处理、后处理步骤,均已开源。此外,作者与TensorFlow Agents团队合作,以确保代码能够被完全复现并没有内部依赖。

5. 对芯片设计社区的影响与未来展望

作者指出,AlphaChip不仅在谷歌内部产生了显著影响,还激发了外部学术界和工业界在芯片设计领域的进一步研究和创新。例如,MediaTek的高级副总裁已经宣布他们将AlphaChip应用于他们最先进的芯片开发中,这标志着AlphaChip影响力的进一步扩展。

作者强调,AI在芯片设计中的应用仍处于不断演进的阶段,未来的工作将专注于优化现代亚7nm工艺节点的设计。此外,作者呼吁社区共同开发和评估更多开放的芯片设计基准,以推动该领域的发展。

P.S., AI在芯片设计中的实际案例:Synopsys的产品套件Synopsys.ai/DSO.ai