论文DreamGen: Unlocking Generalization in Robot Learning through Neural Trajectories提出了DREAMGEN这一利用神经轨迹(Neural Trajectories)生成合成数据的通用方法,显著缓解了机器人学习在数据获取与泛化方面的挑战,展示了在多个机器人平台、多个任务与环境中强大的通用性,为机器人通用智能系统的构建提供了全新路径。

论文作者为Joel Jang, Seonghyeon Ye, Zongyu Lin, Jiannan Xiang, Johan Bjorck, Yu Fang, Fengyuan Hu, Spencer Huang, Kaushil Kundalia, Yen-Chen Lin, Loic Magne, Ajay Mandlekar, Avnish Narayan, You Liang Tan, Guanzhi Wang, Jing Wang, Qi Wang, Yinzhen Xu, Xiaohui Zeng, Kaiyuan Zheng, Ruijie Zheng, Ming-Yu Liu, Luke Zettlemoyer, Dieter Fox, Jan Kautz, Scott Reed, Yuke Zhu, Linxi Fan,来自NVIDIA, University of Washington, KAIST, UCLA, UCSD, CalTech, NTU, University of Maryland和UT Austin等多家机构。

一、研究背景与动机

当前通用型机器人学习主要依赖大规模人工遥操作演示数据,虽然在真实任务中表现出色,但这种数据收集方式成本高昂且效率低。虽然合成数据模拟是一种替代方案,但存在工程开销大、物理真实性差、以及仿真到现实(sim2real)迁移困难等问题。为了解决这些瓶颈,本文提出了一种创新的训练数据生成管道——DREAMGEN。它基于最新的视频世界模型,将视频生成与伪动作标注结合起来,从而大规模合成具备物理合理性与语言指导能力的训练数据,大幅降低对人工遥操作数据的依赖。

二、DREAMGEN系统流程与核心思想

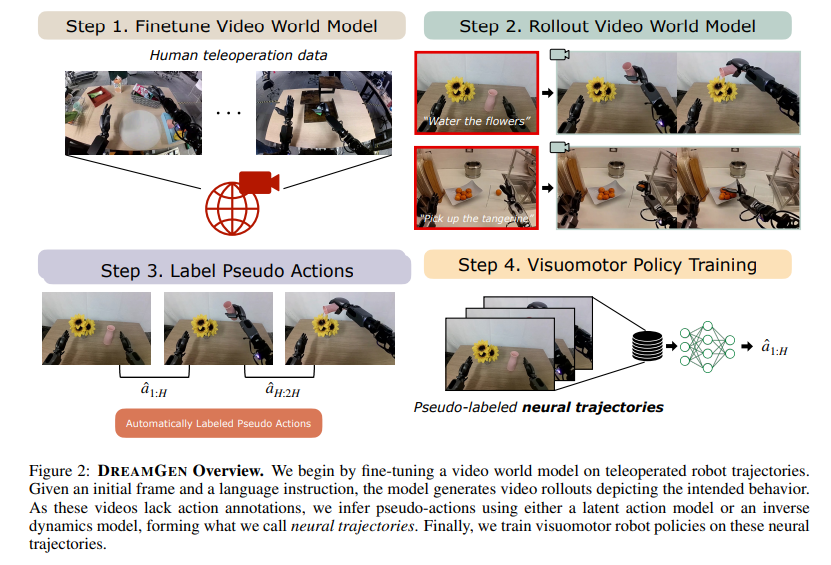

DREAMGEN包括四个核心步骤:(1)对视频世界模型进行微调,使其能够理解目标机器人的物理属性与动作特性;(2)使用初始图像帧与语言指令生成合成视频;(3)对视频序列提取伪动作,形成所谓“神经轨迹”;(4)用这些神经轨迹训练视觉-运动策略模型。视频生成使用如WAN2.1等先进的文本到视频模型,通过微调适应机器人的动作结构,而动作提取则通过两种方法实现:一是使用逆动力学模型(IDM),二是采用隐空间动作模型(LAPA)。最终得到的神经轨迹可用于单独训练或与真实演示数据协同训练策略模型。

三、合成数据增强实验分析

在RoboCasa模拟环境中,作者将神经轨迹数量扩大到原始人类演示数据的333倍,并系统性地比较了不同数据量下的策略性能表现。实验显示,神经轨迹数量与策略成功率呈对数线性增长关系,且即便完全不使用真实演示,仅用IDM伪标注的神经轨迹训练策略,也可达到非零的成功率(约20.6%)。在真实环境中,作者在GR1人形机器人、Franka机械臂与SO-100低成本机械臂上测试了九种不同任务,如叠毛巾、用锤子敲打、舀取M&M糖果等,显示出神经轨迹对真实策略训练有显著提升作用。例如GR1在四项任务中的平均成功率由37%提高至46.4%,Franka由23%提升至37%,SO-100由21%提升至45.5%。

四、行为与环境泛化能力验证

行为泛化方面,仅基于“取放(pick-and-place)”的遥操作数据,DREAMGEN便使机器人能够完成22项从未演示过的新行为任务,如倒水、点燃蜡烛、使用吸尘器、熨衣服等。在“已知环境+新行为”测试中,使用DREAMGEN训练的策略平均成功率达43.2%,而基线模型为11.2%。

环境泛化方面,作者仅用一个实验室环境下的演示数据微调视频模型,在没有额外遥操作数据的情况下,仅通过初始图像帧生成并训练策略,便实现了对十种全新环境的迁移。在“新环境+新行为”任务中,平均成功率为28.5%,而基线模型完全为0%。这代表了真正意义上的“zero-to-one”泛化能力。

五、DreamGen Bench基准构建与评价体系

为系统性评估视频世界模型适应机器人任务的能力,作者构建了DreamGen Bench评测系统,主要从两个维度评估:指令遵循度(Instruction Following, IF)与物理合理性(Physics Alignment, PA)。采用包括GPT-4o、Qwen2.5-VL和人工评审在内的多种方式进行评分。结果显示,微调后的Cosmos与WAN2.1模型在各项评估中表现最佳。尤其值得一提的是,DreamGen Bench得分与实际策略在RoboCasa任务中的成功率高度正相关,这说明视频模型的表达能力直接影响下游策略性能。

六、方法优势与实用性

DREAMGEN最大优势在于其可扩展性和低人工依赖。通过视频模型与伪动作模型分离设计,不依赖在线实时生成,兼容多种机器人形态与任务场景。与传统依赖真实遥操作数据的模仿学习方式相比,其合成数据生成的成本低、扩展快,适合构建规模化机器人学习体系。

七、研究限制与未来方向

当前工作仍有几点限制:(1)DREAMGEN依赖一定算力资源,例如生成24万个神经轨迹耗时达54小时,使用1500张NVIDIA L40 GPU;(2)初始帧需人工提供,尚无法完全自动化;(3)目前任务相对简单,未能覆盖全部机器人动作能力;(4)自动评价指标(如视频物理真实性)仍有幻觉问题。未来可从提升视频模型物理建模能力、自动采集初始帧、支持更复杂任务、以及联合训练IDM和策略等方向继续推进。

DREAMGEN:https://research.nvidia.com/labs/gear/dreamgen