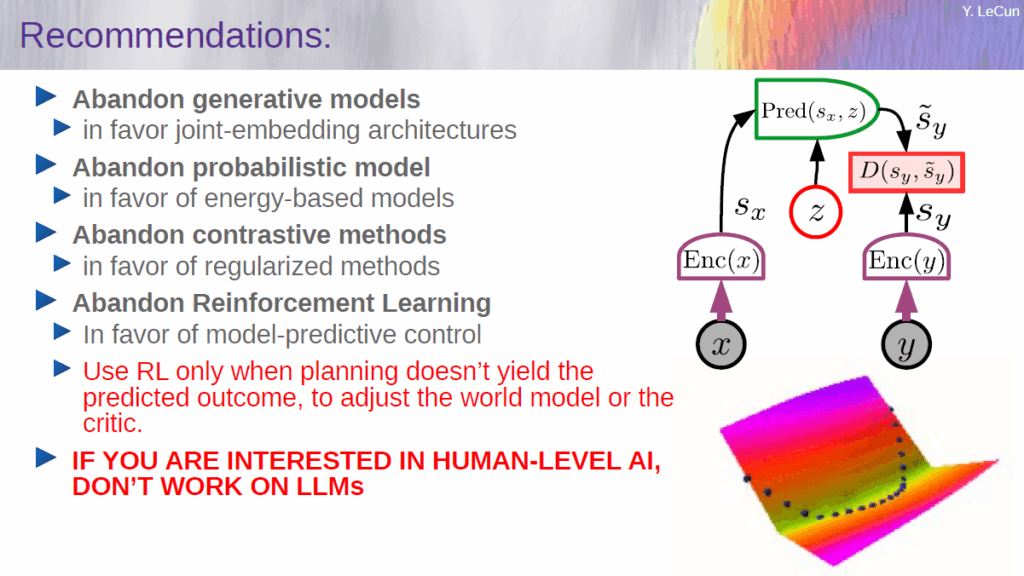

近期,杨立昆(Yann LeCun)教授发表演讲Shaping the Future of Artificial Intelligence,详细阐述其技术观点和团队最新的研究成果。其中观点之一:用能量模型(EBM)取代概率模型(Probabilistic)。

能量模型(Energy-Based Models,EBMs)是一种通用而强大的机器学习建模框架,它并不直接建模输出的概率分布,而是通过定义一种“能量函数”来表示输入和输出是否匹配的好坏,从而实现分类、回归、生成、规划等多种任务的统一建模。

EBM 的核心思想是,定义一个能量函数 F(x,y),表示输入 x 与输出 y 之间的“不相容程度”(energy),并假设:

- 好的配对(匹配数据)具有低能量

- 不好的配对(错误结果)具有高能量

信息技术领域,对于用数学方法解决现实问题,从历史上看,概率论往往胜出。

将上述疑问抛给ChatGPT,得到如下回答(有一定参考价值):

这是一个非常深刻的问题。在信息技术和更广泛的人工智能、通信、控制、统计等领域,概率论确实在历史上发挥了主导作用,这是有充分理论、实践与哲学基础的。但今天我们也看到如能量模型(EBM)、对比学习、变分方法等非概率范式正在崛起。这一演化背后有多个层面的逻辑:

一、为什么概率论长期“胜出”

- 表达不确定性是核心需求

现实世界充满了不确定性,而概率论提供了一种系统化方法来描述和处理这些不确定性(如噪声、缺失、模糊、选择性观察等)。

从通信中的香农信息论,到贝叶斯分类器,再到神经网络中的 dropout,本质都是概率模型在工作。 - 理论基础成熟

概率论拥有严密的数学体系,配合测度论、统计学发展,能够确保一致性、收敛性与泛化能力的理论分析。 - 早期技术高度依赖统计建模

在数据量稀缺、模型能力有限的时代(20 世纪中叶至 2000 年前后),概率方法是从小样本中提取结构信息的唯一可行方法。 - 与优化自然结合

MAP(最大后验)、MLE(极大似然)等方法将概率模型与数值优化紧密结合,使其成为实际可用的方法论体系。

二、概率方法的“胜出”并非绝对

尽管概率论提供了巨大的成功,但也有其显著局限性:

- 建模假设过强

高维复杂世界中,很难找到合适的概率分布(如图像、视频、动作轨迹、文本)。这使得显式建模 P(x,y) 或 P(y∣x)在实践中变得不切实际。 - 推断开销高昂

尤其是在深度学习兴起之后,显式概率方法(如变分推断、MCMC)往往代价高、收敛慢,训练不稳定。 - 生成式建模瓶颈

像 GAN、VAE 虽使用概率语言表达,但其核心目标往往并非真的建模“真实分布”,而是优化某种可训练的打分函数。EBM 的出现正是对此的反思。

三、能量模型等非概率方法的崛起

Yann LeCun 提倡的能量模型、JEPA、VICReg 等范式的优势在于:

- 灵活性强:只需学习一个打分函数 F(x,y),而不需要归一化为概率分布。

- 更接近“决策-优化”流程:推理过程是直接的目标最小化(如规划、控制),而非通过贝叶斯积分。

- 更易与物理世界建模一致:物理系统中的能量最小化本身就是最自然的建模方式。

- 高维建模优势:在图像、视频、动力学系统中,能量方法比概率方法更稳定、可扩展。

四、我(ChatGPT)的看法:概率是工具,而非真理

概率论是人类建模不确定性的一种高度成功的方法论,但它不是唯一,也不是普适适用。可以类比如下:

- 概率模型:是“基于数据分布的建模”,强调“世界可能是什么样”。

- 能量模型与优化式建模:是“基于结构与目标的建模”,强调“我们希望世界如何运作”。

这两者并不对立,而是互补的两种建模哲学。未来的智能系统很可能需要两者融合——比如:

- 用概率捕捉数据不确定性与模糊性;

- 用能量或优化目标构建可控、安全、推理型系统。

五、未来的可能趋势

- 概率方法将在低维、监督学习场景中继续主导

- 能量模型与结构优化方法将在高维、自监督、规划与控制等任务中取代概率

- 信息几何与能量地形分析将成为新的数学工具,替代传统的概率论基础

- 新的数学范式可能进一步融合拓扑学、微分几何、群论与能量方法

P.S, 上述回答来自ChatGPT,而杨立昆(Yann LeCun)教授对以大模型为代表的生成式模型(generative models)也是唱衰的😄:

大语言模型(LLMs)的问题:LeCun 认为当前基于自回归的 LLMs(如 GPT)虽在语言处理上取得突破,但无法实现真实世界理解和控制。他指出其不可控、不可事实化、错误率积累导致输出质量迅速恶化(P= (1-e)n),从根本上“注定失败”。