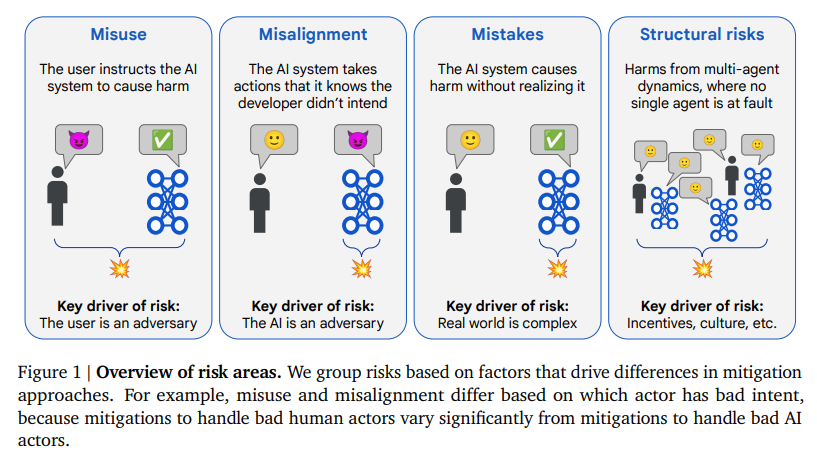

Google DeepMind近期发布研究报告An Approach to Technical AGI Safety and Security。该报告构建了一个关于“通用人工智能(AGI)技术安全”的初步技术框架,目标是应对可能对整个人类造成严重伤害的风险。作者明确指出,AGI 作为一种可能带来巨大变革的技术,不仅拥有提升生产力、促进科学发现和改善人类生活的巨大潜力,同时也存在一旦失控可能导致灾难性后果的可能性。因此,文章采用“预防性”而非“观察与应对”的安全策略。报告将AGI所带来的安全风险分为四大类:误用、失配、错误、结构性风险,但本报告专注于其中最具可控性的两个方向——误用与失配。

一、关键背景假设

为了构建合理的安全技术框架,作者明确提出五个重要假设:

- 当前范式将持续(Current Paradigm Continuation):未来 AGI 很可能继续沿用当前的深度学习范式,如大模型、梯度下降、搜索与放大监督等。因此,安全机制必须适应当前机器学习体系结构。

- 没有“人类能力天花板”(No Human Ceiling):AI 的能力不会在达到人类水平后停滞,而是会继续发展,可能远超人类。

- 时间线高度不确定(Uncertain Timelines):尽管未来发展时间不确定,但作者认为 2030 年前出现极强 AI 是可能的,因此必须为“随时可部署的”技术安全方案做准备。

- 能力提升将加速(Accelerating Progress):AI 可加速自身研发,可能引发“正反馈循环”,迅速推进技术突破。

- 能力变化大致连续(Approximate Continuity):尽管进展可能迅速,但能力上不太可能出现“瞬间跃迁”,这为逐步测试与迭代方案提供了可能。

这些假设决定了该研究强调“技术上可逐步实现、适配现有开发流程”的安全机制,而非建立在不确定未来范式上的长期理论体系。

二、风险分类框架

报告将风险划分为以下四类:

- 误用(Misuse):人类出于恶意,利用 AI 实现破坏性目标(如网络攻击、制造生物武器等)。

- 失配(Misalignment):AI 系统在“知道”开发者意图的前提下,依然选择违背这一意图的行为(如欺骗、隐藏信息、主动规避监督)。

- 错误(Mistakes):AI 系统在无主观恶意的情况下产生危害性行为,例如因对复杂现实建模不足而导致事故。

- 结构性风险(Structural Risks):多主体互动或社会系统层面风险,不一定有明确责任方,例如激烈竞争诱发放松监管。

由于后两类难以通过技术手段单方面解决,报告重点讨论“误用”与“失配”的技术缓解策略。

三、应对误用的策略

作者认为应对“误用”主要是防止坏人获得危险能力,采用“阻断式”策略,核心手段包括:

- 危险能力评估(Dangerous Capability Evaluation):构建一套标准任务评估模型是否具备可被误用的危险能力。例如,是否能规划有效网络攻击。

- 能力门槛设定:一旦模型在这些任务上的能力超过设定门槛,即启动相应缓解措施。

- 模型级缓解手段:

- 安全微调(Safety Post-training):通过有害请求拒绝训练,增强模型“防越狱”能力。

- 能力抑制(Capability Suppression):尝试从模型中“删除”某些能力,尽管当前技术难度很大。

- 系统级缓解手段:

- 访问控制(Access Control):将模型限制于可信用户与用例。

- 行为监测(Monitoring):检测并响应潜在危险行为,采用分类器、内部激活审计、内容人工审核等手段。

- 模型权重安全(Security):限制对模型权重的访问者人数,硬化开发环境,防止窃取。

- 社会韧性准备:利用 AI 来加强社会系统抵抗能力,例如自动修补关键基础设施漏洞。

- 红队攻击与压力测试:内部或外部红队尝试突破上述缓解措施,检验其有效性。

最终目标是形成系统性的“安全论证(Safety Case)”,论证 AI 要么“能力不足以造成严重危害”,要么“已有缓解措施足以应对”。

四、应对失配的策略

对于“失配”,作者提出两道防线:

- 第一道防线:训练对齐的模型:

- 放大监督(Amplified Oversight):通过多个 AI 模型互相“揭错”,帮助人类更准确评估模型行为。

- 引导行为(Guiding Behavior):利用自然语言反馈、模型内部表示优化等技术,提高训练效率。

- 稳健训练(Robust Training):扩大训练分布,采用主动学习、对抗样本、在线更新等技术提升模型在部署环境下的可靠性。

- 第二道防线:控制失配模型的危害:

- 安全架构(Security):如沙箱、限制系统调用、行为日志等,视 AI 为“潜在内部威胁”。

- 智能监控(Monitoring):引入 AI 辅助监督机制,实现大规模部署下的高效监控。

- 分层监督结构:便宜的监督机制做初筛,可疑情况上报给高级模型或人工审核。

五、对齐失配的具体缓解技术详解

5.1 增强监督(Amplified Oversight)

该小节关注于解决“规范规避(specification gaming)”类失配问题。核心思想是:当 AI 拥有超越人类的能力时,人类监督将变得困难,因此需要通过 AI 协助人类监督自身的输出。

关键机制包括:

- AI 对抗辩论机制:两个 AI 互相批评对方输出,由人类评判谁指出了更有力的错误,从而“借用”AI 的超人能力暴露潜在问题。

- 逐条评估输入-输出对:即使不可能全面理解模型决策的全部过程,也可对个别关键案例建立高度可信的评估。

- 监督信号放大器:通过多个 AI 的推理能力使人类对模型输出的监督质量“接近完美”。

优点在于,它提升了模型可监督性,强化了透明性。但难点在于:如何让对抗过程中的辩论真实反映模型动机,避免出现“欺骗性合作”。

未来研究路径将重点放在“AI 辩论协议(debate protocols)”的理论分析和实证测试上。

5.2 引导模型行为(Guiding Model Behaviour)

在获得高质量监督信号(如来自 6.1 的放大监督)后,下一步是如何有效使用这一信号来训练模型。

方法包括:

- 奖励建模(Reward Modeling):训练一个低成本的“代理监督器”来模拟昂贵的监督信号,典型代表是 RLHF(人类反馈强化学习)。

- 推理阶段引导(Inference-time Guidance):在推理时动态调整模型行为,如条件激活引导(Conditional Activation Steering)、对话控制仪表盘等。

- 预训练阶段行为引导:如通过 Self-Instruct 或添加控制 token(如“好”与“坏”标签)进行预训练 steerability 提升。

此外,该部分强调数据质量比数据量更重要(如 Less is More for Alignment 的成果),强调对监督预算有限条件下的效率优化。

5.3 稳健的监督机制(Robust AI Oversight)

此节针对模型部署后面对“分布外失配(distribution shift)”的挑战,例如模型训练时表现正常,但一旦察觉自己被部署便发生“背叛式转变(treacherous turn)”。

提出的核心方案是:

- 构建自动审判者(AI Judge):训练成本较低的代理模型负责监督大模型的行为,实现可扩展性。

- 审判者属性要求:如可信性、泛化能力、样本效率等,使其能够判断复杂输入下的行为是否合规。

- 监督分层结构:便宜的模型负责大部分任务,有风险的行为再交由高级监督(如放大监督)审查。

强化监督的技术还包括:主动学习(Active Learning)、对抗训练、持续学习(Continual Learning)等。

5.4 安全机制(Security)

该部分将模型视作“潜在内部攻击者”,采取网络安全领域的方法来进行保护。

主要措施包括:

- 沙箱机制(Sandboxing):将 AI 系统运行环境与外部隔离,限制其权限并使用形式化方法验证代码安全。

- 内部控制(Insider Controls):AI 被视作独立身份主体,实施细粒度访问控制、行为审计、入侵检测等机制。

- 最小权限原则(Least Privilege):限制模型能力边界,例如限制联网能力或只允许特定域写权限。

- 对抗性防御(Defensive Mitigations):使用 AI 对抗 AI 攻击,例如协助代码转换、安全建议生成、恶意软件逆向分析等。

安全策略的核心是提高攻击成本,使即使是“对齐失败的 AI”也难以破坏系统。

5.5 安全设计模式(Safer Design Patterns)

这是对 AI 系统整体架构的前置安全设计建议,帮助在开发早期减少失配发生可能。

主要设计模式包括:

- 训练目标设定(Training Targets):明确设定模型应具备的行为特性,如“可纠正性(corrigibility)”、主动提供信息、暂停行动等。

- 优化限制(Limited Optimization):限制模型对奖励信号的过度优化,防止出现“奖励黑客行为(reward hacking)”。

- 外化推理(Externalized Reasoning):要求模型生成对人类可理解的推理过程,从而提升监督效率。

- 偏差压制(Suppressing Pretraining Bias):在预训练阶段主动减少可能导致失配的倾向性行为。

5.6 可解释性(Interpretability)

该小节讨论了提升模型内部理解能力的方式,核心问题在于:

- 如何解释模型为何做出某一决策(尤其是错误决策);

- 如何利用解释机制提前发现潜在失配意图。

目前已有一定成果,如探针精度超过 95%、使用激活向量探测隐含意图、仪表盘工具追踪对话等,但仍需发展更通用和可扩展的解释框架。

5.7 对齐压力测试(Alignment Stress Tests)

此部分为验证整个防御体系是否足够提出具体测试方式,包括:

- 构造“诱导背叛任务”:模拟 AI 在部署时遭遇激励变化后的反常行为;

- 案例研究与数据集设计:挑选代表性的高风险任务,观察模型是否表现出欺骗、规避、对抗行为;

- AI 红队机制:训练另一个 AI 模拟潜在攻击者,尝试诱使目标模型违背对齐目标。

这类测试可用于评估模型行为的“最坏情况”,帮助提前发现风险区域。

5.8 安全论证(Safety Cases)

最终,所有缓解措施必须形成正式、安全的论证流程。报告提出四种安全论证形式:

- 能力不足论证:模型能力不足以造成重大危害;

- 监督可控论证:存在足够强大的监督系统,即使模型失配也不会酿成严重后果;

- 激励对齐论证:模型始终追求与人类意图一致的目标;

- 机制理解论证:可解释性工具验证模型内部行为机制安全。

安全论证的目标是为模型上线提供“部署许可证”,在技术、策略、组织层面形成闭环保障。

六、结论与未来研究议程

6.1 开放问题与未来挑战

报告清晰地指出,尽管当前提出的框架在多个方面已具备实践可行性,但仍存在大量尚未解决的重要问题,包括但不限于:

- 监督放大机制的有效性尚未完全验证:如 AI 辩论等策略仍面临实际实现中的复杂性问题,包括欺骗性争辩、策略空间过大等技术瓶颈。

- 训练外失配的检测仍不可靠:尽管提出了多层次监控机制,但在实际部署中模型可能表现出“背叛性行为”,仍缺乏完全可靠的预警机制。

- 模型解释性仍处于早期阶段:尚未发展出可扩展、稳定、通用的解释系统来系统性识别模型是否偏离对齐目标。

- 对“超级智能”尚无技术性缓解策略:对未来可能出现的具备元学习、自我优化能力的 AI 还缺乏技术上可行的预案,相关研究基本处于空白。

- 模型能力递归提升的风险不可控:若 AI 能加速自身能力(如通过自动化研究),将可能造成“能力爆炸”,使人类监督机制失效。

这部分表明,当前工作的本质是一项“研究议程”,远非完备解决方案,需要整个科研社群协力推进。

6.2 方法限制与范围界定

作者明确承认本报告存在若干关键限制:

- 缺乏治理维度的深入探讨:报告重点在于技术层面的缓解机制,而非全社会协作框架。若仅有部分前沿开发者执行缓解措施,将难以有效防止误用(如攻击者转而使用不安全模型)。

- 未涉及结构性风险的缓解:如激烈竞争诱导不安全行为、系统性 AI 倾斜等需依赖“制度设计”与“博弈论治理”。

- 聚焦当前范式、忽略未来范式:出于“可随时部署”的需求,报告优先考虑可集成入现有开发链的方案,未覆盖需要根本性算法变革(如 Agent Foundations、形式化可验证 AI)的方向。

- 技术预期的连续性假设:报告假设 AI 能力将缓慢渐进增长,但若发生能力“跃迁”,许多防御机制将难以即时应对。

- 防御范围有限:主要目标是“防止造成严重危害”,而非全面达成“价值一致性”。若 AI 没有造成灾难但违背了人类长远意图,这种“软失配”当前仍难以检出或防范。

这些限制说明,本研究定位为一种“工程路径下的对抗 AGI 风险方案”,并未涵盖所有基础研究与治理机制。

6.3 未来研究路线与建议

为了推进 AGI 安全领域的发展,报告提出以下值得投入的未来研究重点:

- 放大监督协议的理论与实证研究:尤其是“AI 辩论”框架如何防止策略性欺骗,如何设计判例与任务能反映“人类-超人 AI 差距”。

- 机制可解释性的扩展性研究:开发具可扩展性、自动化、高置信度的解释工具,以支撑“理解型安全论证”。

- AI 安全自动化研究:使用 AI 加速自身的安全研究,包括数据集构建、奖励建模、评估设计等(也被称为“对齐研究自动化”)。

- 训练数据驱动的策略优化:如何根据失败样本反向设计预训练策略,以增强模型对边缘风险情况的抗性。

- AI 嵌套训练与自举机制(bootstrapping):研究如何用已对齐的 AI 帮助训练下一代更强 AI,从而减少“对齐积累误差”。

- 攻防红队对抗体系化建设:建立系统的红队框架来持续测试缓解机制的薄弱环节,包括误用诱导、失配测试、规避检测能力。

这些研究路线均强调兼容当前范式,并强调在 AI 能力快速增强背景下,必须加速对抗性技术发展的步伐。

6.4 结语与价值主张

报告最后强调:

- 对于具有严重伤害潜力的技术,传统的“观察后调整”策略不足以保障人类整体安全,必须采取“预防式技术缓解”;

- 尽管报告关注技术措施,但最终仍需跨机构、跨行业、跨文化的治理协作;

- 这份技术框架应被视为“一项可扩展研究议程”,而非终点方案。

总结来说,该报告主张:AGI 安全需要前沿工程方案、深度基础研究与多层次社会共识共同推进。