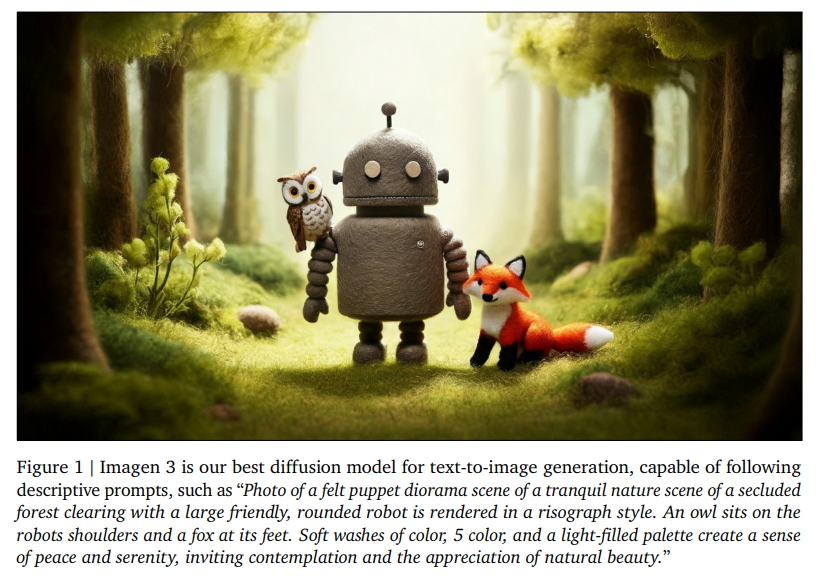

Imagen 3 是由谷歌团队开发的最新文本生成图像(Text-to-Image, T2I)模型,该模型为潜在扩散模型(Latent Diffusion Model),主要针对高质量图像生成和文本提示的复杂理解进行了优化。

模型相关研究内容及成果在论文Imagen 3中发表,论文作者为Google Imagen 3 Team成员。

如下为论文内容概要介绍:

1. 模型架构与训练过程

1.1 模型架构

Imagen 3 是一个潜在扩散模型,结合了扩散模型的图像生成能力和潜在空间的表示优势。扩散模型通过逐步引入噪声生成数据,而潜在扩散模型则在潜在空间中执行这一过程,从而提高了生成效率并降低了计算复杂度。

在默认配置下,Imagen 3 能够生成分辨率为 1024×1024 的图像,并支持 2倍、4倍或8倍的上采样,以进一步提高图像的分辨率和细节表现力。

1.2 数据集与预处理

模型训练所用的数据集包括大量配对的图像和文本描述。为了保证数据质量,论文详细介绍了一个多阶段的数据过滤过程,包括:

- 安全过滤:移除不安全、暴力或低质量的图像。

- 去除AI生成的图像:避免模型学习这些图像中可能存在的伪影或偏差。

- 去重处理:减少训练数据中过于相似的图像,以防止模型过拟合特定图像元素。

- 合成标题生成:通过Gemini模型生成多样化的合成标题,提升数据集的语言多样性。

1.3 模型训练

模型在谷歌最新一代的TPU硬件上训练,使用了JAX库进行大规模并行计算。TPU硬件特别适合处理大规模模型训练所需的巨大计算量,并通过高带宽内存支持更大的模型和批量处理。

2. 模型评估

2.1 人工评估

论文中对Imagen 3进行了广泛的人工评估,主要包括以下几个方面:

- 总体偏好:评价用户对生成图像的整体满意度。

- 提示-图像对齐:评估生成的图像与输入文本提示的匹配程度。

- 视觉吸引力:衡量图像的美观度,不考虑内容。

- 细节提示对齐:特别针对复杂长文本提示的图像生成能力进行测试。

- 数值推理:评估模型生成包含特定数量对象的图像的准确性。

通过对不同模型的比较,如DALL·E 3、Midjourney v6和Stable Diffusion 3,Imagen 3在大部分评估指标中表现优异,尤其是在细节提示对齐和数值推理方面,显示出了领先优势。

2.2 自动化评估

除了人工评估,论文还使用了几种自动化评估方法来衡量模型的性能:

- CLIP:一种常见的对比编码器,用于评估文本与图像的对齐度。

- VQAScore:基于视觉问答(VQA)的方法,用于更细粒度的图像内容评估。

实验结果表明,VQAScore在评估文本-图像对齐时表现出更高的准确性,与人工评估的相关性达到了80%。这表明VQAScore在区分相似模型时比CLIP更为可靠。

3. 责任与安全性

3.1 安全措施

在训练和部署过程中,论文强调了对安全和责任问题的重视。具体措施包括:

- 数据预处理:包括数据过滤、去重和生成多样化的合成标题,以确保模型不会生成潜在有害的内容。

- 训练后处理:使用工具如SynthID水印技术,对生成内容进行标记,以减少误用或错误信息传播的风险。

3.2 公平性评估

为了避免生成图像中出现的性别、年龄或肤色的偏见,论文中对模型生成的人物图像进行了自动化的公平性评估。结果表明,Imagen 3 在减少这些偏见方面表现优于之前的版本(Imagen 2),尤其是在生成更具多样性的人物形象方面有显著提升。

4. 模型局限性与未来方向

尽管Imagen 3在多方面表现出色,但论文也指出了其局限性,特别是在处理涉及复杂推理任务(如数值推理和空间推理)时仍存在挑战。未来的研究方向可能包括:

- 提升模型的推理能力:特别是在涉及数量、规模和组合场景的生成任务中。

- 进一步提高公平性:通过优化模型的训练和评估流程,减少生成图像中的潜在偏见。