论文Evolving Deeper LLM Thinking提出了一种创新的进化搜索策略——Mind Evolution,旨在通过更加高效地利用推理时间计算资源,提升大型语言模型(LLM)在解决复杂问题时的推理能力。传统的LLM解决问题方法往往依赖于单一的推理步骤或固定的推理路径,而Mind Evolution通过引入基因搜索的思想,结合自由流动的随机探索与大规模的迭代优化,寻求更加灵活和高效的解决方案。

论文作者为Kuang-Huei Lee, Ian Fischer, Yueh-Hua Wu, Dave Marwood, Shumeet Baluja, Dale Schuurmans, Xinyun Chen,来自Google DeepMind, UC San Diego, University of Alberta。

一、研究背景与问题概述

在过去的研究中,有多种策略用于利用推理计算资源,如链式思维(Chain-of-Thought)、自一致性(Self-consistency)、反馈驱动的逐步修正(Sequential Revision)、以及依赖辅助验证器或评估器的搜索策略(如Best-of-N和树搜索)。这些方法通常依赖于明确的推理步骤或启发式的反馈过程来逐步改善解答,而Mind Evolution则通过一套全新的进化算法,将问题解的生成与反馈结合,避免了需要明确形式化问题的需求,极大地扩展了其应用场景。

具体来说,Mind Evolution通过以下两个重要特点区分于其他方法:

- 自由探索与精细调整的结合:该方法不仅进行广泛的探索(类似于Best-of-N),同时还在多次迭代中对最有潜力的解进行深度调整,从而提高了找到最佳解的可能性。

- 无需逐步评估过程:不同于树搜索等逐步推理方法,Mind Evolution采用全球性的解的优化策略,只需要一个全局的解评估器,而不必逐个评估推理步骤。

此外,Mind Evolution采用的进化搜索方法能够并行处理大量解候选,适合在多核计算环境下实现高效计算。

二、方法与技术框架

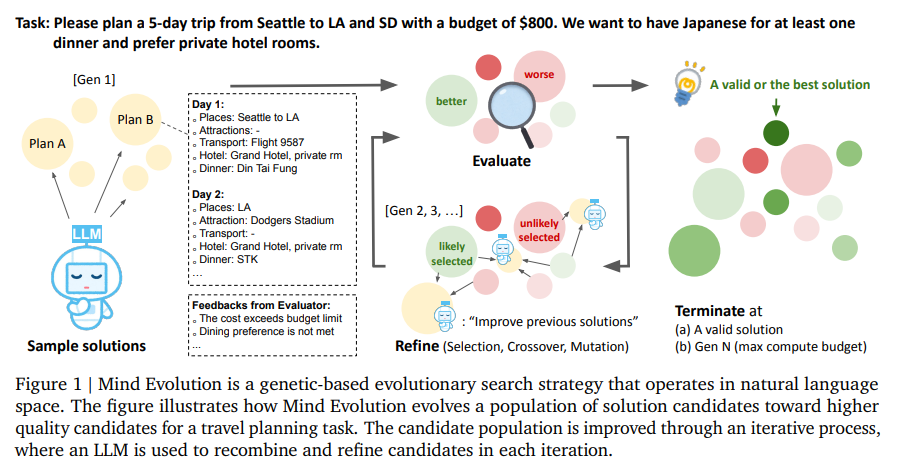

Mind Evolution结合了基因搜索算法与LLM的生成能力,核心思想是利用进化策略在自然语言空间中高效搜索解决方案。整个过程包括候选生成、适应度评估、交叉与变异操作,以及多代迭代优化,最终通过全球评估选择最佳解决方案。

2.1 基因搜索算法概述

基因算法(Genetic Algorithm,GA)是一种模仿自然选择过程的搜索优化算法,能够通过模拟生物进化过程中的“选择、交叉与变异”来寻找问题的最优解。在Mind Evolution中,基因搜索的每一代都会对候选解进行评分,选择表现较好的解进行交叉与变异,生成新的候选解,这一过程不断重复,直到找到满足要求的解或达到计算预算。

Mind Evolution的实现流程如下:

- 候选生成:通过LLM生成初始解。在问题描述和相关提示的帮助下,LLM可以生成多个候选解。

- 适应度评估:使用预设的评估函数对候选解进行打分。评估函数根据候选解是否满足给定的约束条件(如预算、时间、位置等)以及其整体质量(如符合度、创新性等)来为解赋值。

- 交叉与变异:通过交叉操作将多个高适应度解进行组合,变异操作则随机改变解的部分内容,以增加解的多样性。

- 迭代优化:该过程会在多代之间不断迭代,通过精细的交叉与变异操作产生更加优秀的解,逐步优化问题的解决方案。

2.2 提升批判性思维的RCC过程

Mind Evolution引入了“批判性对话”(Refinement through Critical Conversation,RCC)过程,这是提升模型批判性思维的关键所在。在此过程中,LLM通过“批评者”和“作者”两个角色进行交替工作:

- 批评者角色:分析候选解,并根据评估结果给出改进建议,指出解的缺陷或不满足的约束。

- 作者角色:根据批评者的反馈进行改进,提出新的解,并继续提交给批评者进行分析。

这种批判性思维的分离帮助模型进行深度自我反省,使得解的质量逐步提高。RCC过程类似于“反思”算法(Reflexion),通过多轮对话的方式改进解,使其更加符合问题要求。

2.3 岛屿模型与种群多样性

Mind Evolution采用岛屿模型(Island Model)来维护种群的多样性,避免进化过程中的过度收敛。具体而言,岛屿模型将解的种群分为多个子群体,这些子群体之间进行周期性的迁移和重置,从而保持种群的多样性,避免陷入局部最优解。每个岛屿上的解集在一定数量的代数后会进行迁移,即优质解从一个岛屿迁移到相邻岛屿,通过这种方式加速整个进化过程。

2.4 全局优化与并行化

Mind Evolution的优化过程是全局性的,意味着它通过一次性评估完整解而非单步推理,这使得该方法能够更高效地使用推理计算资源。此外,该方法适合并行化,可以在多核计算环境下并行生成和评估多个解,显著提升计算效率。

三、实验设计与结果分析

论文在多个自然语言规划任务上验证了Mind Evolution的有效性,尤其在TravelPlanner、Trip Planning和Meeting Planning这三个任务中展现了明显的优势。

3.1 旅行计划(TravelPlanner)

任务描述:TravelPlanner是一个自然语言规划基准任务,要求模型生成满足用户需求的旅行计划。问题通过自然语言描述一系列的约束条件,如预算、餐饮偏好等,任务的目标是生成符合这些约束条件的旅行计划。

实验结果:在TravelPlanner任务中,Mind Evolution表现出了压倒性的优势。与传统的Best-of-N方法(成功率55.6%)和Sequential Revision方法(成功率82.8%)相比,Mind Evolution达到了95.6%的成功率,几乎解决了所有的验证集问题。当使用更强大的Gemini 1.5 Pro模型时,Mind Evolution成功率达到了100%。

3.2 自然计划——旅行规划(Trip Planning)

任务描述:Trip Planning任务要求生成一个符合时间和城市约束的旅行行程,确保用户能够在指定的时间和地点完成旅行,并且所有的约束条件得到满足。

实验结果:在此任务中,Mind Evolution同样超越了基线方法,验证集成功率为96.2%,测试集成功率为94.1%。特别是,Mind Evolution在处理多城市规划时,比Best-of-N方法(成功率77.2%)和Sequential Revision方法(成功率74.4%)表现得更加稳定和高效。

3.3 自然计划——会议安排(Meeting Planning)

任务描述:在会议安排任务中,模型需要安排多个会议,最大化与尽可能多的与会者的会议数量,且满足时间、地点等约束。

实验结果:Mind Evolution在会议安排任务中的表现也非常突出。验证集成功率为85.0%,测试集成功率为83.8%。使用Gemini 1.5 Pro模型的两阶段方法后,成功率提升至98.4%。相比之下,Best-of-N方法仅达到了69.4%的成功率,Sequential Revision方法的成功率为62.0%。

3.4 新任务——隐秘诗歌(StegPoet)

任务描述:StegPoet是一个新引入的任务,要求将隐藏的信息编码到一篇创意文本(如诗歌)中,文本需要遵循特定的主题和结构,并确保信息的隐秘性。

实验结果:在StegPoet任务中,Mind Evolution的验证集成功率为46.5%,使用Gemini 1.5 Pro模型时提升至87.1%。与基线方法相比,Mind Evolution能够在此复杂任务中展示出其搜索和优化的潜力,尽管这个任务很难形式化。

四、组件分析与消融实验

通过一系列的消融实验,作者探讨了Mind Evolution各个组件的作用,揭示了批判对话(RCC)过程在提升解质量方面的重要性。具体来说:

- 批判性分析步骤:禁用批判者步骤会显著降低Mind Evolution的性能(从95.6%降至46.1%)。这证明了批判性分析对于模型性能的至关重要性。

- 岛屿模型:使用岛屿模型显著提高了解的多样性和算法的收敛速度。禁用岛屿模型时,性能下降了10%。

- 文本反馈:文本反馈的加入大幅提升了解的优化质量,反馈机制能够帮助模型更好地理解约束条件并进行相应调整。

五、研究意义与局限性

5.1 研究意义

Mind Evolution的引入为自然语言规划问题的解决提供了一个新的方向,特别是在无需明确形式化问题的情况下,它能够在多个复杂任务中表现出卓越的性能。这一方法不仅对自然语言处理(NLP)领域的发展有重要意义,也为优化推理计算资源提供了新的视角。

5.2 局限性

尽管Mind Evolution在自然语言规划任务中表现优异,但目前该方法仍然局限于能够通过程序化评估的任务。未来的研究将致力于开发更通用的LLM评估器,以扩展其应用范围,并探索其他类型任务的优化可能性。