来自Google Research的Juan Manuel Zambrano Chaves、来自Google DeepMind的Eric Wang以及其他多名研究人员近期在论文Tx-LLM: A Large Language Model for Therapeutics中提出了Tx-LLM概念,即一种用于治疗学的大语言模型。

论文介绍Tx-LLM探索了这一新可能性。与大多数治疗学AI模型不同,Tx-LLM是一个通用模型,设计用于理解多种生物实体——小分子、蛋白质、DNA、细胞系、疾病——并能够在66个治疗任务中交替使用自由文本。

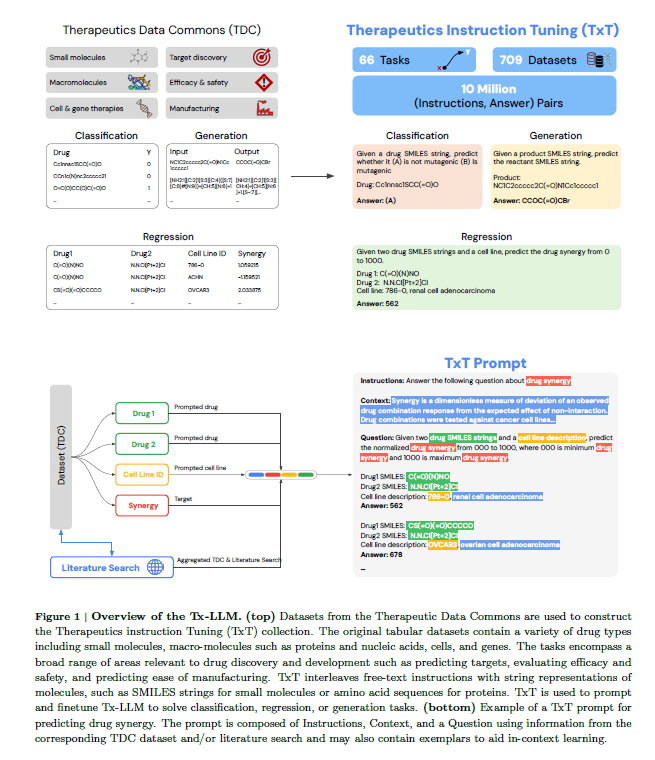

论文研究人员在覆盖药物发现管道各个阶段的709个数据集上训练了Tx-LLM,这些数据集涵盖了66个任务。使用来自Therapeutic Data Commons (TDC)的数据集构建了𝗧𝗵𝗲𝗿𝗮𝗽𝗲𝘂𝘁𝗶𝗰𝘀 𝗶𝗻𝘀𝘁𝗿𝘂𝗰𝘁𝗶𝗼𝗻 𝗧𝘂𝗻𝗶𝗻𝗴 (𝗧𝘅𝗧) 集合。TxT将自由文本指令与分子字符串表示交织在一起,例如小分子的SMILES字符串或蛋白质的氨基酸序列。TxT用于提示并微调Tx-LLM,以解决治疗领域的分类、回归或生成任务。使用这种组合,Tx-LLM在相当数量的这些任务中展示了令人鼓舞的结果,达到了或超过了最先进的性能(SOTA)。

Tx-LLM的通用性质使其能够预测多种与治疗相关的属性。在66个任务中,Tx-LLM在43个任务上接近SOTA表现,并在22个任务上超越SOTA。Tx-LLM在将分子信息(如SMILES表示)与文本上下文(如细胞系或疾病名称)结合的任务中表现尤为出色,这一优势可能源于其在预训练期间获得的广泛知识。

一个令人兴奋的发现是,Tx-LLM似乎能够在不同药物类型的任务之间传递知识,例如涉及小分子和蛋白质的任务。这可能支持使用通用模型,用相同的字符串表示表达多种药物类型,而不是为每种药物类型使用单独的表示。

Tx-LLM: A Large Language Model for Therapeutics

以下为论文总体概述:

1. 引言

论文介绍了Tx-LLM,这是一种专为治疗学设计的大型语言模型,旨在加速药物研发。当前大多数AI方法仅限于特定领域的任务,而Tx-LLM则通过在709个数据集上进行训练,覆盖药物发现管道的66个任务,展示了其在多种化学和生物实体(如小分子、蛋白质、核酸、细胞系、疾病)上的预测能力。模型在43个任务上表现优于或接近最先进水平(SOTA),并在22个任务上超过SOTA。

2. 相关工作

文章回顾了大型语言模型(LLMs)的发展,特别是在自然语言处理、化学和生物学中的应用。它还讨论了专为治疗学设计的专家模型的局限性,强调了Tx-LLM作为通用模型的优势。

3. 方法

3.1 数据集

- 数据来源:Tx-LLM的数据集来自Therapeutic Data Commons (TDC),覆盖药物研发的各个阶段。

- 数据格式:每个数据集被格式化为文本提示,包括指令、上下文、问题和答案。数据集的类型包括二元分类、回归和生成任务。

3.2 模型

- 基础模型:Tx-LLM基于PaLM-2模型,通过少量示例提示进行微调。

- 微调:使用TxT训练数据对PaLM-2进行微调,训练单一模型来处理所有TDC数据集。

3.3 评估

- SOTA表现:评估Tx-LLM在TDC数据集上的表现,结果表明Tx-LLM在43个任务上超过或接近SOTA。

- 任务迁移:通过对比训练在所有数据集上的模型和仅在小分子数据集上的模型,发现不同类型药物任务之间存在正迁移。

4. 结果

4.1 TDC数据集上的表现

- 整体表现:Tx-LLM在66个任务中,43个任务上达到或超过SOTA,其中22个任务显著超越SOTA。

- SMILES和文本数据集:对于包含SMILES和文本的数据集,Tx-LLM表现尤为出色,可能是因为在预训练期间学习到的上下文信息。

4.2 数据集间的正迁移

- 正迁移效果:在所有数据集上训练的模型在小分子数据集上的表现优于仅在小分子数据集上训练的模型,表明不同类型药物数据集之间存在正迁移。

4.3 消融研究

- 模型规模和微调:较大的模型规模和领域微调显著提升了模型表现。

- 提示策略:不同数量的提示和选择方式对性能的影响不显著。

- 上下文移除:移除上下文信息会显著降低模型性能,特别是在包含多个子任务的数据集中。

5. 讨论

Tx-LLM是首个在多种TDC数据集上训练的通用LLM模型,展示了在药物研发各个阶段的潜在应用。然而,模型仍在研究阶段,未来可能需要结合其他先进模型(如Gemini系列)来进一步提升性能。此外,实验验证仍是药物开发过程中的关键步骤。

6. 结论

Tx-LLM通过统一多个任务的通用模型,为药物开发提供了一个新的方向。尽管需要进一步发展和验证,Tx-LLM展示了AI在提升药物开发效率方面的巨大潜力。