论文Do generative video models learn physical principles from watching videos?开发了Physics-IQ这一基准数据集,专门用来测试生成性视频模型在理解物理原则方面的能力。研究的目标是检验当前模型是否能够从观察中掌握诸如固体力学、流体动力学、光学、磁学和热力学等领域的基本物理规律。

论文作者为Saman Motamed, Laura Culp, Kevin Swersky, Priyank Jaini, Robert Geirhos,来自Google DeepMind。

一、引言

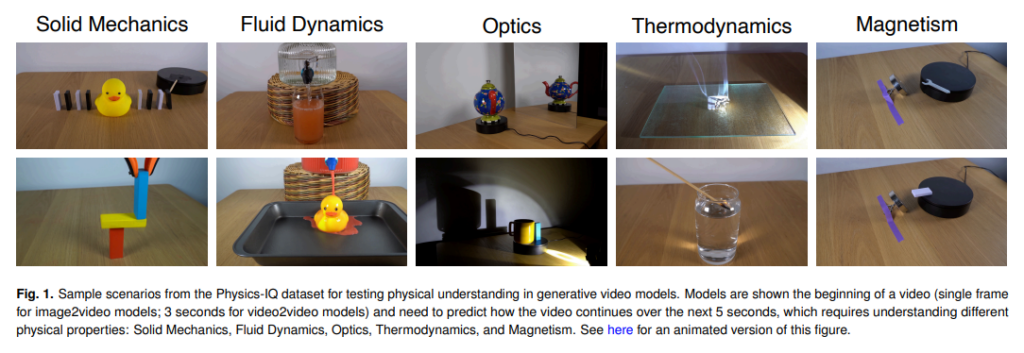

随着生成性视频模型的快速发展,其生成的内容在视觉真实感上取得了显著突破。这些模型不仅吸引了研究者的关注,也引发了关于其学习能力的争论:生成性视频模型是否能够从观看视频中学会现实世界的物理原则,还是仅仅在进行复杂的像素预测?为了深入探讨这一问题,研究者开发了Physics-IQ这一基准数据集,专门用来测试生成性视频模型在理解物理原则方面的能力。研究的目标是检验当前模型是否能够从观察中掌握诸如固体力学、流体动力学、光学、磁学和热力学等领域的基本物理规律。

这项研究的意义不仅在于评估当前生成性视频模型的能力,也在于为未来的研究提供方向。如果模型可以通过观看视频学习物理原则,这将为构建通用人工智能(AGI)铺平道路。然而,视觉真实感是否意味着物理理解,目前仍是一个未解之谜。研究者希望通过这项研究,揭示生成性视频模型在物理理解方面的潜力和局限。

二、研究背景与动机

生成性视频模型的目标是通过预测未来帧来生成连贯的动态场景。理论上,这种预测任务应该要求模型理解现实中的物理原则。例如,要预测一个物体的运动轨迹,模型需要了解重力和动量守恒的基本原理。同样,预测液体的流动也需要一定的流体力学知识。

支持这一观点的学者认为,视频预测任务可以迫使模型学习物理原则,因为只有掌握物理规律,模型才能生成合理的预测结果。这种观点类比于语言模型的学习方式:通过预测下一个词,语言模型能够学会语法、语义甚至隐含的知识结构。此外,人类的大脑也通过预测感官输入来构建世界模型,这一认知理论进一步支持了生成性视频模型可能具备学习能力的假设。

然而,也有学者提出相反的观点,认为仅通过观察视频而不与环境交互,模型无法真正理解物理原则。缺乏交互能力使模型无法区分因果关系与简单的关联性。例如,一个模型可能注意到物体掉落后地面会产生声音,但并不真正理解这是由于重力作用。这种局限性表明,仅靠观察,模型可能更倾向于依赖训练数据中的模式而不是理解物理规律。

三、Physics-IQ基准数据集的设计

Physics-IQ基准数据集的设计旨在弥补现有物理推理测试数据集的不足,特别是过度依赖合成数据的问题。研究者认为,合成数据与真实数据之间的分布差异可能会对模型性能的评估产生混淆,因此他们专注于构建基于真实视频的数据集。

Physics-IQ数据集包含396个高质量视频,涵盖66种不同的物理场景。每个视频时长为8秒,从三个不同视角(左、中、右)拍摄,并在相同条件下重复录制两次,以捕捉现实世界中物理变化的随机性。这些场景涉及多个物理学领域,包括但不限于以下几个方面:

- 固体力学:如多米诺骨牌的连锁反应、物体的碰撞与反弹。

- 流体动力学:如液体的流动、混合和波动。

- 光学:如光的反射、折射和阴影的变化。

- 磁学:如磁性物体的相互作用。

- 热力学:如温度变化引起的物质反应。

数据集的每个场景通过静态摄像机捕捉,视频分辨率为3840×2160像素(16:9宽高比),以确保清晰度和细节完整性。每个场景的视频分为两部分:前3秒用于提供条件,后5秒用于测试模型的预测能力。

为了确保测试的严谨性,研究者还引入了多个评价指标,用于衡量模型在不同维度上的表现。

四、评价指标与实验设计

评价指标是衡量模型物理理解能力的核心。研究者设计了以下四个主要指标:

- 空间交并比(Spatial IoU)

该指标评估生成视频中动作发生的位置是否正确。例如,在多米诺骨牌被中断的场景中,模型应该能够正确预测哪些骨牌会倒下,哪些骨牌会保持不动。 - 时空交并比(Spatiotemporal IoU)

此指标进一步考虑动作发生的时间维度,即模型是否能正确预测动作的时间节点和时序。 - 加权空间交并比(Weighted Spatial IoU)

该指标评估动作发生的位置及其强度。例如,一个滚动的球与一个摆动的钟摆在运动轨迹上的表现会有所不同。 - 均方误差(MSE)

该指标在像素级别衡量生成视频与真实视频的差异,特别关注物体的外观和运动是否一致。

实验设计中,模型需要根据提供的3秒条件视频或单帧图像,预测接下来的5秒视频。部分模型还可以使用文本描述作为附加条件。

五、实验结果与分析

实验结果表明,当前生成性视频模型在物理理解上存在显著不足。尽管某些模型在特定场景中表现出一定的理解能力,但整体得分远低于物理变化的随机性上限(100%)。具体分析如下:

- 整体表现

VideoPoet(多帧)模型在所有评估模型中得分最高,但其Physics-IQ得分仅为24.1%。这表明即使是当前最先进的模型,在物理理解方面仍有很大提升空间。 - 类别表现

不同模型在物理类别上的表现差异显著。例如,在固体力学场景中的表现明显优于流体动力学和光学场景。这可能是由于固体力学场景的规律相对直观,而流体和光学现象更加复杂且难以预测。 - 视觉真实感与物理理解的关系

实验还发现,视觉真实感与物理理解之间没有显著相关性。一些模型虽然生成了视觉效果极佳的视频,但其物理预测往往与真实情况相悖。例如,一个模型可能生成高分辨率的视频,但其中的物体运动完全不符合物理规律。

六、讨论与未来展望

研究揭示了当前生成性视频模型在物理理解上的几个关键问题:

- 模型的局限性

生成性视频模型缺乏与环境交互的能力,使其难以学习因果关系。此外,模型常常受到训练数据分布的限制,可能对某些常见模式产生过度依赖。 - 评价指标的改进空间

尽管研究者设计了多个指标来评估模型的物理理解能力,但这些指标仍然无法直接量化具体的物理现象。未来的研究需要开发更精确的指标,以更全面地评估模型的表现。

未来的改进方向包括:

- 扩展数据规模

提供更大规模、更多样化的真实视频数据集,以帮助模型更好地学习不同的物理规律。 - 引入交互式学习

通过交互任务使模型能够观察因果关系,从而提高其对物理现象的理解。 - 优化模型架构

结合时间序列建模和物理知识嵌入,可能有助于提高模型的预测能力。

研究者还提出了一个开放问题:生成性视频模型能否仅通过扩大训练规模实现对物理原则的深刻理解,或者必须通过交互式学习才能突破这一瓶颈?这一问题的答案将决定未来生成性视频模型的发展路径。

七、总结

Physics-IQ基准数据集的引入,为评估生成性视频模型的物理理解能力提供了重要工具。研究表明,当前模型尽管在视觉真实感上取得了显著进展,但对物理原则的理解仍处于初级阶段。未来的研究需要在数据、算法和评估方法上进行全面创新,以推动这一领域的发展。

Physics-IQ Website: https://physics-iq.github.io/

Physics-IQ Benchmark on GitHub: https://github.com/google-deepmind/physics-IQ-benchmark