深度神经网络(DNN)在各种任务上取得了巨大成功,其中一个关键因素是大规模训练数据的可用性。然而,在存储受限的情况下,高效训练深度网络仍然是一个重大挑战。数据集蒸馏(Dataset Distillation)技术被提出用于将大规模数据集压缩成小规模的合成数据,同时尽可能保留原始数据的分布信息。

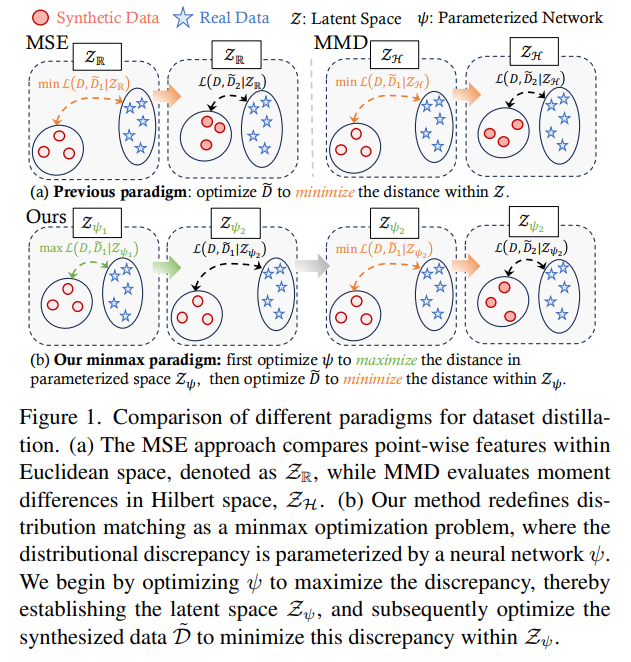

当前数据集蒸馏方法中,以分布匹配(Distribution Matching, DM)为基础的方法因其计算效率和优越性能而备受关注。然而,现有的距离度量方法(如均方误差MSE和最大均值差MMD)在衡量分布差异时存在不足,无法准确刻画真实数据和合成数据之间的分布差异。

论文Dataset Distillation with Neural Characteristic Function: A Minmax Perspective提出了一种新的数据集蒸馏方法,将数据集蒸馏问题重新表述为一个极大极小(minmax)优化问题,并引入了神经特征函数差异(Neural Characteristic Function Discrepancy, NCFD),作为一个理论上完备的分布测度。NCFD利用特征函数(Characteristic Function, CF)来描述数据的完整分布信息,并通过神经网络优化CF的采样策略,以最大化真实数据和合成数据之间的分布差异,从而提高分布匹配的准确性。

本文的方法,神经特征函数匹配(Neural Characteristic Function Matching, NCFM),在合成数据和真实数据的特征匹配过程中,能够在复数平面中同时对幅度(Amplitude)和相位(Phase)信息进行对齐,实现数据真实性与多样性之间的平衡。实验表明,该方法在多个低分辨率和高分辨率数据集上均取得了显著的性能提升。相比当前最先进的方法,论文提出的方法使得GPU 内存使用量减少了 300 倍以上,处理速度提升了 20 倍。特别是在CIFAR-100数据集上实现了无损蒸馏,仅使用2.3GB GPU显存即可在单张NVIDIA 2080 Ti上完成训练。

论文作者为Shaobo Wang(王少波), Yicun Yang, Zhiyuan Liu, Chenghao Sun, Xuming Hu, Conghui He, Linfeng Zhang,来自Shanghai Jiao Tong University(上海交大), Hong Kong University of Science and Technology和Shanghai Artificial Intelligence Laboratory。

一、背景知识和相关工作

1. 数据集蒸馏方法

数据集蒸馏技术可分为:

- 基于梯度匹配:通过匹配真实数据的梯度信息来优化合成数据。

- 基于轨迹匹配:通过匹配训练轨迹来优化合成数据。

- 基于分布匹配:通过匹配特征分布来优化合成数据。

2. 特征函数作为分布测度

特征函数是概率分布的一种完备表示方式,由概率密度函数的傅里叶变换定义。相较于均方误差和最大均值差等方法,特征函数能够提供更完整的分布信息。虽然在生成模型领域已有一些方法利用特征函数进行分布匹配,但其在数据集蒸馏中的应用仍未被深入研究。

3. 传统分布匹配方法

- 点对点特征匹配:直接比较数据点的特征值,但无法刻画高维流形中的分布结构。

- 矩匹配:通过匹配高阶矩来衡量分布间的相似性,但不能保证分布的一致性。

二、对抗分布匹配

1. 极大极小优化框架

为克服传统方法的不足,本文将分布匹配问题转化为一个极大极小优化问题。在该框架下:

- 优化神经网络参数,以最大化分布差异度量,从而定义一个更鲁棒的分布测度;

- 优化合成数据,以最小化该分布差异度量,使得合成数据更接近真实数据。

2. 神经特征函数匹配

(1)神经特征函数差异

特征函数能够刻画数据的完整分布信息。基于特征函数,本文定义了一种新的分布测度,即特征函数差异,该方法能够同时衡量数据在复数空间中的幅度和相位差异:

- 幅度信息:描述数据的整体分布范围,影响数据的多样性;

- 相位信息:描述数据的特征中心,影响数据的真实性。

(2)优化采样策略

本文通过一个参数化的采样网络来动态优化特征函数的采样策略,以确保分布匹配过程中能更高效地选择关键的频率分量。

(3)基于神经特征函数的分布匹配

最终的优化目标是通过最小化特征函数差异来匹配合成数据和真实数据的分布,同时通过神经网络学习更有效的测度。

三、实验

1. 主要结果

- 在CIFAR-100数据集上,相较于最优基线方法,本文方法提升了20.5%的准确率。

- 在ImageSquawk数据集上,该方法比最先进方法提高了20.5%的准确率。

- 在GPU计算方面,该方法比现有方法节省300倍显存,并提高20倍计算速度。

2. 消融实验

- 是否使用采样网络:使用采样网络可提升约3%-10%的准确率。

- 幅度与相位的影响:二者结合可达最优性能(幅度提供多样性,相位增强真实性)。

- 采样频率参数数量:1024个采样参数时效果最佳,过多采样收益递减。

四、讨论

- 训练稳定性:相比其他对抗优化方法,该方法在优化过程中更稳定。

- 与最大均值差的关系:特征函数差异可视为最大均值差的特殊情况,具有更好的分布描述能力。

Neural Characteristic Function Matching(NCFM)on GitHub: https://github.com/gszfwsb/NCFM