应美国国家科学院的邀请, Tom Mitchell(卡内基梅隆大学,CMU)和Eric Horvitz(Chief Scientific Officer of Microsoft)共同撰写了这篇题为Scientific Progress in Artificial Intelligence: History, Status, and Futures(《人工智能的科学进展:历史、现状与未来》)的概述。文章不仅探讨了AI作为一门学科的起源和演变,还深入分析了AI技术中的关键创新和挑战,展望了AI在未来可能的研究方向与应用场景。

1. 人工智能的定义与目标

人工智能(AI)最早由美国人工智能促进会(AAAI)定义为“追求理解思维和智能行为机制并将其体现在机器中的科学研究领域。”它涵盖了诸如数据学习、知识表示、推理、问题解决、规划、语言理解和视觉感知等多种能力。AI的核心目标是开发能够模仿人类智能执行任务的系统。AI在过去20年从一个小众的学术领域,迅速发展成为影响广泛的技术领域,应用范围遍布工业、医疗、教育等多个领域。

2. 人工智能的历史背景

- 早期思想的形成:尽管AI的现代定义出现在20世纪,但思考如何通过机械化系统模拟人类思维的想法可以追溯到数百年前。20世纪早期的关键理论突破,包括图灵的可计算性理论、冯·诺依曼的通用计算机设计,以及麦卡洛克和皮茨关于神经网络系统的计算抽象研究,都为AI的未来发展奠定了基础。

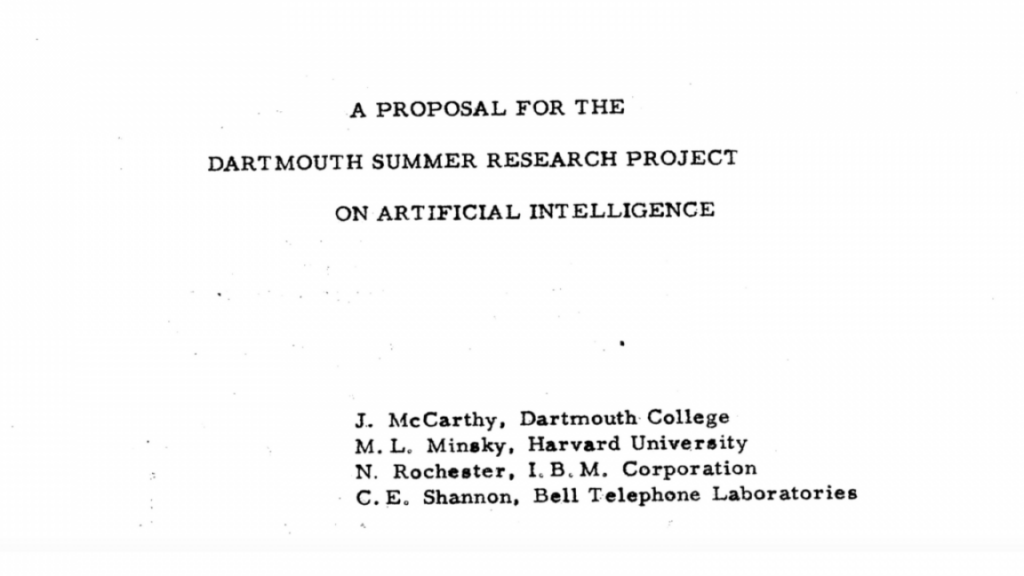

- 1956年达特茅斯会议:AI的诞生标志性事件是1956年达特茅斯夏季会议,由约翰·麦卡锡、马文·明斯基、纳撒尼尔·罗切斯特和克劳德·香农共同撰写的会议提案首次使用了“人工智能”一词。该提案设定了AI的研究目标:使机器能够使用语言、形成抽象和概念、解决问题,并自行改进。此次会议被视为AI作为独立学科的正式开端,并为之后的几十年奠定了研究方向。

- AI子领域的形成:随着AI学科的逐渐成熟,研究领域开始分化为多个子领域,如自然语言处理、问题解决、视觉、机器人学和机器学习等。不同的研究社区逐渐形成,并围绕符号推理、统计方法和神经网络等不同的技术路径展开研究,形成了AI的多样性。

3. 表示与推理机制的技术演进

AI的发展历程可以通过其在表示和推理机制上的技术演变来理解:

- 符号推理的主导:在AI发展的前几个十年,符号表示和逻辑推理占据了主导地位。专家系统(如基于规则的“if-then”推理)曾在1970年代和1980年代广受关注,尤其是捕捉专家知识并应用于特定领域的推理系统。

- 从逻辑到统计:到了1980年代中期,AI研究开始从符号逻辑推理转向统计方法,特别是在医疗诊断和决策支持等现实应用中。贝叶斯网络等概率模型逐渐兴起,帮助AI系统处理现实世界中大量不确定性的问题。统计推理不仅可以基于现有数据进行推断,还可以通过计算额外信息的预期价值来指导收集更多数据。

- 神经网络的回归与崛起:尽管神经网络研究早在1960年代便已开始,但其在早期的发展中被符号方法所掩盖。到了21世纪,神经网络(尤其是深度学习)再次崛起,成为推动AI领域快速发展的核心技术。早期的神经网络,如感知机和多层感知机(MLP),逐渐演变为今天的深度学习系统,并在多个领域(如计算机视觉和语音识别)取得突破。

4. 机器学习作为现代AI的基础

机器学习是当前AI技术的核心。文章中详细解释了机器学习如何通过从数据中学习来改进任务性能:

- 监督学习:通过使用带标签的数据集,机器学习算法能够学习如何进行分类和预测。文章中提到的经典例子是信用卡欺诈检测系统,该系统通过分析大量历史交易数据,学习哪些交易可能是欺诈。

- 非监督与自监督学习:无监督学习无需标签数据,通过发现数据中的模式来进行分析。而自监督学习则是一种新兴的重要方法,它利用大量未标注的数据集,通过“填空”形式的任务(如预测下一个单词或图像中的缺失部分)来进行训练。这种方法显著降低了对人工标注数据的依赖,推动了大规模预训练模型(如BERT和GPT)的发展。

- 深度学习的突破:深度学习通过多层神经网络的方式实现了自动学习复杂的表示,使AI在多个领域取得了显著的进展。特别是2009年在Switchboard语音识别任务上的突破,以及2012年AlexNet在ImageNet竞赛中的成功,标志着深度学习时代的到来。深度学习不仅在语音、图像等领域表现优异,还在医疗影像分析中表现出专业水准(如CheXNet系统对肺炎的准确诊断)。

5. 生成模型与判别模型

AI模型可以大致分为生成模型和判别模型:

- 判别模型:判别模型通过学习数据与标签之间的关系进行分类。例如,垃圾邮件过滤器通过分析邮件特征,将其分类为垃圾邮件或非垃圾邮件。判别模型使用如逻辑回归、支持向量机、深度神经网络等方法来完成分类任务。

- 生成模型:生成模型通过学习数据的分布来生成类似于训练数据的新数据。例如,生成对抗网络(GANs)通过学习如何生成逼真的图像,而Transformers等生成模型则通过预测下一个词或图像片段来生成连续的数据。这类模型已经广泛应用于图像生成、文本生成、科学模拟和蛋白质设计等领域。

6. AI的关键创新:Transformer架构

文章特别提到了Transformer架构在AI中的重要性。由Vaswani等人提出的Transformer模型通过“注意力机制”在序列生成时学习如何关注输入序列的不同部分,这使得模型能够理解更广泛的上下文。这一创新不仅应用于自然语言处理,还在图像处理和多模态数据建模中表现出色。Transformer模型结合自监督学习,在自然语言生成、翻译、文本生成等任务中取得了巨大的成功。

7. 自监督学习与指令微调

自监督学习结合了大规模多样化数据集的训练,使得AI模型能够从未标注的海量数据中学习,这也是像BERT和GPT等基础模型取得成功的关键。指令微调(Instruction Tuning)是另外一个重要的创新,它通过让模型学习如何根据自然语言指令执行任务,并通过人类反馈进一步改进模型的输出。这种方法增强了模型与人类的交互能力,使得AI能够更自然地理解并响应人类的需求。

8. 生成AI的第二次转折

文章认为,生成AI已经进入了第二次转折期,AI不仅能够生成文本和图像,还能进行复杂的推理和跨领域的任务处理。以GPT-4为代表的生成AI系统展示了卓越的多领域推理能力和“多才多艺”的表现。未来,随着生成AI技术的不断成熟,这类系统在日常生活和科学研究中的应用将更加广泛。

9. AI未来的研究方向与挑战

文章还讨论了多个未来的研究方向:

- 表征学习与推理:如何在深度学习模型中自动学习复杂的表示,并将其应用于多模态数据的融合和推理,仍然是AI研究的热点。

- 记忆与适应:当前的深度学习模型在面对新数据时无法像人类一样灵活地学习和适应。文章指出,未来的AI系统需要能够快速学习和适应实时数据,这将改变当前模型只能通过重新训练来更新知识的局限。

- 架构创新:Transformer架构虽然强大,但在处理长时间依赖和多步骤规划时存在不足。未来的研究将探索新的模型架构,以应对这些挑战。

- 可靠性与信任:随着AI在医疗、司法等高风险领域的应用,AI系统的可靠性和安全性变得尤为重要。未来研究的一个关键方向是如何提高AI系统的可信度,特别是在生成模型容易“幻觉”出错误信息的情况下,如何设计更好的校准和验证机制。

10. 小型开源模型与个性化AI的未来

未来,开源的小型模型可能会引发AI技术的民主化,使更多的研究人员和开发者能够参与到AI的进步中。文章还指出,个性化AI的趋势正在兴起,这类模型将能够根据个人或企业的特定需求进行调整,为用户提供量身定制的服务。