论文Molmo and PixMo: Open Weights and Open Data for State-of-the-Art Multimodal Models中,作者通过提出一种全新的人类语音标注图像描述数据集,及一系列开源的多模态模型,构建了一整套具备先进性能的开源多模态模型家族,名为Molmo。这些模型通过结合视觉编码器和语言模型,能够生成详细的图像描述并回答视觉问题,而这些数据和模型完全依赖开源资源,摆脱了对专有系统的依赖。

论文作者为Matt Deitke, Christopher Clark, Sangho Lee, Rohun Tripathi, Yue Yang, Jae Sung Park, Mohammadreza Salehi, Niklas Muennighoff, Kyle Lo, Luca Soldaini, Jiasen Lu, Taira Anderson, Erin Bransom, Kiana Ehsani, Huong Ngo, YenSung Chen, Ajay Patel, Mark Yatskar, Chris Callison-Burch, Andrew Head, Rose Hendrix, Favyen Bastani, Eli VanderBilt, Nathan Lambert, Yvonne Chou, Arnavi Chheda, Jenna Sparks, Sam Skjonsberg, Michael Schmitz, Aaron Sarnat, Byron Bischoff, Pete Walsh, Chris Newell, Piper Wolters, Tanmay Gupta, Kuo-Hao Zeng, Jon Borchardt, Dirk Groeneveld, Jen Dumas, Crystal Nam, Sophie Lebrecht, Caitlin Wittlif, Carissa Schoenick, Oscar Michel, Ranjay Krishna, Luca Weihs, Noah A. Smith, Hannaneh Hajishirzi, Ross Girshick, Ali Farhadi和Aniruddha Kembhavi,来自Allen Institute for AI和University of Washington。

以下为论文概要内容:

一、研究背景与现状

目前,多模态模型在人工智能领域中具有显著的进展,特别是在能够理解图像与文本的同时做出推理和生成反应方面。然而,最先进的VLMs(vision-language models)大多是专有的,例如GPT-4、Claude 3.5等,研究者难以获取其权重、数据集和模型架构,无法进行深入的研究。这使得开源社区在研究高性能多模态模型时面临诸多限制。

Molmo的提出是为了填补这一空白,通过构建完全开源的高性能多模态模型,帮助学术界和开发者摆脱对专有系统的依赖。当前的开源模型大多依赖于专有模型生成的合成数据,而Molmo系列则是通过全新的人类标注数据集PixMo来构建,无需借助专有系统的数据。

二、Molmo模型家族的创新点

Molmo家族模型的主要创新在于其构建方式完全依赖开源数据和模型架构,且不使用任何专有系统的合成数据。作者通过结合独立预训练的视觉编码器(如OpenAI的ViT-L/14模型)和语言模型(如OLMo-7B、Qwen2-7B等),构建了一套可以在多模态任务上表现优异的模型。

此外,Molmo的训练数据主要来自一个全新的人类语音标注数据集——PixMo。与传统的文字标注方式不同,PixMo数据集通过让标注者用语音描述图像的方式,生成了更详细且丰富的图像描述。这一“语音描述”创新极大地提高了数据的质量和收集效率,避免了标注者在传统的文字描述中可能忽略细节或复制专有模型输出的问题。

三、Molmo模型架构设计

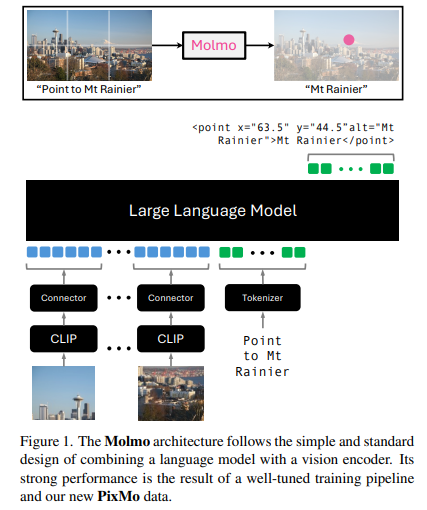

Molmo模型架构采取了标准的多模态设计,结合了视觉编码器和语言模型。模型包含以下四个主要组件:

- 预处理模块:将输入图像转换为多尺度、多裁剪的图像集。

- 视觉编码器:独立处理每一张图像,并将其映射为一组视觉标记(vision tokens)。

- 连接器:将视觉标记投影到语言模型的输入维度,并通过多层感知机(MLP)进行处理,减少标记数量。

- 解码器:使用基于Transformer架构的解码器(如GPT类模型)生成最终的文本描述。

Molmo家族模型的构建基于不同的视觉编码器和语言模型组合。所有模型的训练数据和训练流程基本一致,区别主要在于优化器的学习率以及所选的模型规模。视觉编码器采用了OpenAI的ViT-L/14模型,语言模型则提供多种选项,覆盖不同的规模和开放性。例如,使用完全开源的OLMo-7B模型或Qwen2 72B模型。

四、数据集与训练流程

Molmo模型的训练流程分为两个阶段:

- 第一阶段:图像描述生成的多模态预训练:

- 使用PixMo数据集进行训练,PixMo的数据集完全由人类注释者通过语音描述图像生成。这些图像来自互联网上的各种类型的图片,涵盖了70多个不同的主题(如街头标志、模糊的照片等)。每张图像都有至少三位标注者进行语音描述,描述时长在60到90秒之间。

- 标注者被引导回答一系列问题,包括“图像中的物体是什么?”、“有多少个物体?”、“这些物体的位置如何?”、“背景有什么?”等,以确保图像描述的全面性和细节。

- 收集到的语音通过自动语音识别(ASR)系统转换为文本,再通过语言模型进行后处理,以确保文本的质量和一致性。每张图像的最终描述为三位标注者的转录描述,以及语言模型对这些转录的总结。

- 最终,PixMo数据集包含71.2万张图像和约130万条描述,成为Molmo模型的核心训练数据。

- 第二阶段:监督微调:

- 在图像描述生成预训练完成后,模型进入监督微调阶段。微调数据来自学术界广泛使用的多个数据集,同时作者也开发了多种新数据集,包括:

- PixMo-AskModelAnything:用于模拟现实世界中用户可能提出的各种问题,共收集了16.2万对问题-答案数据。

- PixMo-Points:这一数据集专注于训练模型理解和操作二维点。通过人类标注者在图像中指出特定位置并进行描述,训练模型通过“指向”方式进行回答和推理,这增强了模型的计数能力和解释能力。

- PixMo-CapQA:基于PixMo的图像描述,生成了21.4万对问题-答案数据。

- PixMo-Clocks:一个专门针对模拟时钟的合成数据集,用于训练模型读取时钟时间的能力,包含82.6万个示例。

- 在图像描述生成预训练完成后,模型进入监督微调阶段。微调数据来自学术界广泛使用的多个数据集,同时作者也开发了多种新数据集,包括:

五、Molmo模型的评估与性能

Molmo家族的模型在11个常用的学术基准测试中进行了评估,并且进行了大规模的人类偏好测试。其1B参数的MolmoE-1B模型在性能上接近GPT-4V,表现极为优异。

在学术基准测试中,Molmo-72B模型表现最佳,超过了许多专有系统,如Claude 3.5和Gemini 1.5。作者还引入了人类偏好测试,通过对多达27个多模态模型进行对比,Molmo-72B获得了用户的高度评价,成为仅次于GPT-4o的最受欢迎的模型。

六、Molmo的开放性与未来发布计划

Molmo的另一个重要特性在于其全面的开放性。该项目不仅开放了模型权重、数据集,还计划开放所有的训练与评估代码。与许多专有模型或依赖于专有数据的开源模型不同,Molmo模型完全基于开源的数据与架构,这为学术界和开发者提供了宝贵的资源。

根据论文,作者计划在未来逐步发布更多技术报告和PixMo数据集的详细版本,进一步推动多模态模型的开源研究和应用。

Molmo Demo: https://molmo.allenai.org