空间计算(spatial computing)和人工智能(AI)的进展为扩展现实(extended reality, XR)中的沉浸式互动体验铺平了道路。然而,将物理对象无缝集成到数字环境中仍然是一个挑战。在XR中,现实世界通常被视为一个被动的背景,而大多数互动能力都集中在数字对象上。那如果物理对象可以实时与数字实体无缝融合呢?如果我们可以像在电脑上右键点击文件一样,轻触一个真实物体就能获取相关信息并执行数字操作呢?

在2024年ACM UIST大会上,来自谷歌的研究团队发表的《增强现实对象智能(Augmented Object Intelligence with XR-Objects)》提出了一种新的交互范式——增强对象智能(AOI),旨在使物理对象在XR环境中具备数字互动能力,通过将真实物体智能化,打破数字和物理世界的界限。AOI允许现实世界中的对象成为数字功能的门户,而不需要预注册或手动设置。通过利用实时对象分割和分类技术,结合多模态大语言模型(MLLM),AOI将日常物体转化为XR中的互动工具。

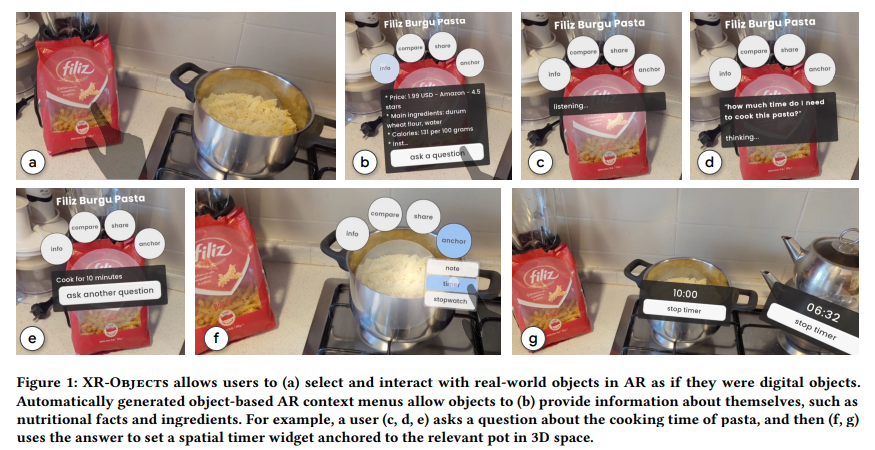

AOI概念通过XR-Objects进行展示,XR-Objects为开源的原型系统,允许用户通过上下文感知的基于对象的菜单与物理环境进行互动。例如,用户可以选择一个现实中的物体,如一锅意大利面,立即获取相关信息(如烹饪时间),或者在3D空间中为锅设置一个视觉锚定的计时器。在这里,模拟物体不仅仅传递信息,还可以触发数字操作。

论文作者为Mustafa Doga Dogan, Eric J. Gonzalez, Karan Ahuja, Ruofei Du, Andrea Colaço, Johnny Lee, Mar Gonzalez-Franco, David Kim,均为谷歌研究团队成员。

以下为研究内容简介:

一、背景与问题

在现代扩展现实(XR)系统中,尽管存在大量传感器、相机和计算机视觉技术,可以将虚拟内容与物理世界融合,但这些技术大多将物理世界视为静态的背景,缺少深度互动。例如,虽然用户可以看到现实世界中的物体与虚拟内容的叠加,但无法与物理对象进行有意义的数字交互。当前的扩展现实应用往往依赖于人工输入或标记物体,而不是实时动态感知和互动。

该研究的核心问题在于:如何使物理世界的对象成为XR环境中的活跃参与者,并像数字对象一样智能化?如何实现无缝的物理与数字互动,从而增强用户体验?为此,论文提出了“增强对象智能”(Augmented Object Intelligence, AOI)的概念。

二、AOI的核心思想

AOI的关键在于让XR系统能够识别物理对象并赋予其数字能力。AOI不仅使物理对象成为信息的载体,还可以触发数字操作。例如,用户可以通过XR界面与锅、土豆等物体互动,以查询信息或执行操作(如设置计时器)。这种交互不再局限于传统的人工输入或标记物体,而是通过实时的对象分割和分类,结合多模态大语言模型(MLLM)的强大自然语言处理能力,实现动态、语义化的物理对象交互。研究的核心创新点如下:

- 无预注册的对象互动:传统的XR系统通常需要预先注册物体信息,才能与这些物体进行交互。但AOI系统利用实时的对象检测和机器学习技术,允许系统自动识别并与未预注册的物体进行互动。这通过提升灵活性,降低了用户的操作复杂性,使得每个物体都有潜力成为数字门户。

- 多模态大语言模型的引入:系统集成了多模态大语言模型(MLLM),使得物体不仅可以通过视觉方式被识别,还能与语音指令进行交互。用户可以通过语音或点击物体来提问,例如“这道菜的烹饪时间是多久?”系统会根据物体上下文生成合适的回答,并可通过3D界面呈现。

三、XR-Objects系统的设计与实现

为了实现AOI的概念,论文开发了一个开源的原型系统XR-Objects。该系统通过实时物体检测和空间定位,实现了物理对象的数字化互动,并结合多模态大语言模型进行自然语言处理。具体设计包括以下几个关键部分:

- 对象检测与分类:XR-Objects通过Google的MediaPipe库进行物体检测,利用卷积神经网络(CNN)在用户摄像头的视图中实时识别对象。这种检测不需要依赖预先标记的物体,而是基于对象的类标签(如“瓶子”、“植物”)和生成的2D边界框来确定物体的位置。

- 3D定位与锚定:为了确保XR界面的交互与现实环境中的物体保持一致,系统通过深度感知技术将物体的2D位置映射到3D空间。例如,系统通过ARCore生成的深度图,结合光线投射(raycasting)技术,将物体从2D图像转换为3D坐标。通过这种方式,XR界面能够在用户移动视角时始终保持与物体的锚定关系。

- 多模态大语言模型(MLLM)集成:系统为每个识别出的对象运行一个专用的MLLM实例。通过将识别到的物体图像输入MLLM,该模型不仅能够生成关于物体的丰富信息(如产品规格、历史背景),还可以处理语音指令,提供更加个性化的互动体验。例如,系统不仅能识别一个“瓶子”,还能进一步识别出这是某种“酱油”,并提供其价格、用户评价等详细信息。

- 上下文菜单互动:XR-Objects的交互通过上下文菜单实现。用户可以通过语音或点击物体触发互动,如提问、分享或设置计时器。当用户点击某个物体时,系统将生成一个基于该物体的上下文菜单,允许用户选择执行不同的操作。这些互动操作被分类为四种主要类型:

- 信息查询:提供物体的相关信息,例如产品成分、价格等。

- 比较:允许用户比较多个物体的信息。

- 分享:用户可以将物体信息分享给联系人。

- 锚定:设置计时器、空间注释等与物体相关的操作。

四、应用场景

XR-Objects系统通过多个实际案例展示了其在不同场景中的应用潜力:

- 烹饪场景:用户可以在厨房中通过XR-Objects系统识别食材,查询营养信息,甚至为烹饪步骤设置计时器。例如,用户可以通过点击锅中的意大利面来自动设置烹饪计时器,这比手动输入更方便且减少了操作步骤。

- 购物场景:在超市购物时,用户可以通过手机摄像头识别产品,并通过XR-Objects获取有关产品的详细信息,如成分表、价格、用户评价等。如果用户想对比不同品牌的豆类,系统可以自动列出不同品牌的脂肪含量,帮助用户作出决策。

- 学习与发现:系统可以被用于教育场景,用户只需将手机对准某个物体,就可以获得关于该物体的相关知识。例如,用户可以通过系统学习花卉的名称、价格以及养护建议等。这种基于物体的知识检索为教育提供了全新方式,增强了学习的沉浸感。

- 物联网连接:XR-Objects还可以用于控制智能家居设备,如智能音箱、温控器等。用户可以通过语音或触摸操作来调整音量、设置温度等,使物联网设备的控制更加直观。

五、研究实验与用户反馈

为验证XR-Objects的有效性,论文进行了用户研究,比较了该系统与传统的AI助手界面的性能。实验设计包括两个场景:超市购物和家庭任务,用户需要完成一系列基于物体的信息查询和互动任务。实验结果表明:

- 任务完成时间:使用XR-Objects的用户平均完成任务的时间比传统AI助手减少了31%。这表明通过上下文关联的物体互动能够显著提高任务的执行效率。

- 用户满意度:参与者对XR-Objects的用户体验评价较高,尤其是在易用性和响应速度方面。与传统基于文本提示的AI助手相比,XR-Objects提供了更直观、更自然的互动方式,减少了用户的认知负担。

六、未来展望

论文指出,XR-Objects作为一个开源平台,旨在进一步推动增强现实和物联网领域的发展。未来,该系统可能扩展至更多场景,如教育、工业设计等。随着多模态大语言模型的不断进步,XR-Objects有望实现更智能、更个性化的物体互动,为用户提供更加无缝的物理与数字世界的结合体验。

XR-Objects on GitHub:https://github.com/google/xr-objects