论文SANA: Efficient High-Resolution Image Synthesis with Linear Diffusion Transformers详细介绍了Sana框架,它是一种用于生成高分辨率(最高可达4096×4096)的文本到图像生成系统。该系统旨在提高生成速度和效率,尤其是在高分辨率生成任务上,Sana的性能超越了现有大多数方法。

Sana框架通过深度压缩自编码器、线性注意力扩散变换器、解码器驱动的小型LLM文本编码器等多项创新设计,成功实现了高效的高分辨率图像生成。相比于现有的大型模型,Sana不仅在速度和效率上实现了显著提升,而且能够在普通硬件上运行,极大地降低了文本到图像生成模型的使用门槛。通过这一系列的优化和创新,Sana为未来的高分辨率内容生成提供了一个高效、低成本的解决方案。

论文作者为Enze Xie, Junsong Chen, Junyu Chen, Han Cai, Haotian Tang, Yujun Lin, Zhekai Zhang, Muyang Li, Ligeng Zhu, Yao Lu, Song Han,来自NVIDIA(英伟达),MIT(麻省理工)和Tsinghua University(清华大学)。

以下是论文的详细分析介绍:

1. 研究背景

随着扩散模型在文本到图像转换领域的进步,高分辨率的图像生成成为了一个新的技术挑战。当前,许多现有的模型,比如PixArt、Stable Diffusion 3(SD3)、Flux等,采用的参数量巨大,通常在8B到24B不等,这使得它们的训练和推理成本非常高,难以普及使用。因此,Sana的研究目标是开发一种轻量化、高效的文本到图像生成模型,能够在保持高质量和高分辨率图像生成的同时显著降低计算开销,并且能够在普通消费级硬件上运行。

2. Sana架构设计

Sana的架构包含几个核心创新点:

2.1 深度压缩自编码器(Deep Compression Autoencoder)

传统的自编码器(AE)通常只将图像压缩8倍(例如,AE-F8),但Sana引入了一个压缩率高达32倍的自编码器(AE-F32)。通过更大的压缩率,Sana减少了潜在标记的数量,从而大幅降低了训练和生成的复杂度。

- 设计动机:高分辨率图像包含大量的冗余信息,因此在训练和推理过程中,过多的像素信息处理会造成性能瓶颈。通过更高的压缩比例,Sana的自编码器在保证图像质量的同时减少了处理的标记数量,进而提高了训练和推理的效率。

- 具体实现:Sana的AE使用32倍压缩,并将图像的每个像素分解为32个潜在通道(C=32),同时降低了补丁大小(Patch Size)P=1。这种设计保证了在高分辨率图像生成中更有效的压缩和处理能力。

2.2 线性扩散变换器(Linear Diffusion Transformers, DiT)

Sana的另一个关键组件是线性扩散变换器,它通过替换传统的二次自注意力机制(Vanilla Self-Attention)为线性注意力,大幅度减少了计算复杂度。传统的注意力机制具有O(N²)的复杂度,而线性注意力将其降低到O(N),这对于高分辨率图像生成来说是一个巨大的性能提升。

- Mix-FFN模块:Sana还引入了一个Mix-FFN(混合前馈网络)模块,结合了深度卷积层(3×3卷积),使得模型可以更好地捕获局部信息。该设计进一步提升了高分辨率图像的生成能力,特别是在没有位置编码(NoPE)的情况下,仍然保持了出色的性能表现。

2.3 解码器驱动的小型LLM作为文本编码器

传统的文本到图像模型通常使用的是CLIP或T5模型作为文本编码器,它们在理解文本和图像对齐方面存在局限性。Sana则采用了一个基于解码器的小型大型语言模型(LLM),如Gemma-2,来提升文本理解和推理能力。

- 设计理由:与T5相比,Gemma等解码器架构的LLM具备更强的指令跟随能力和推理能力,特别是在复杂的用户指令场景中。通过这种解码器驱动的设计,Sana能够更好地理解用户提供的文本描述,并生成高质量的图像。

- 复杂人工指令(Complex Human Instruction, CHI):Sana在训练过程中引入了复杂的人工指令,借助于LLM的上下文学习能力(In-context Learning),强化了文本和图像的对齐效果。实验表明,加入CHI后,生成的图像质量得到了显著提升。

3. 高效的训练和推理策略

Sana不仅在模型架构上进行了创新,还在训练和推理过程中采用了多项优化策略,以提升生成速度和图像质量。

3.1 自动化的标签生成与选择

在数据集的标注方面,Sana采用了自动化的多重视觉语言模型(VLM)标签生成策略。每张图片都会通过多个VLM模型生成不同的描述,进一步提升了标签的多样性和准确性。然后,Sana通过基于CLIP得分的采样策略,动态选择高质量的标签进行训练,从而提升了训练收敛速度和图像-文本的对齐度。

3.2 Flow-DPM-Solver推理加速

为了进一步加快生成速度,Sana采用了Flow-DPM-Solver,该算法减少了生成步骤,将常规的28-50步推理减少到14-20步。同时,Flow-DPM-Solver引入了新的推理方式,从速度和质量上都超过了Flow-Euler-Solver,使得Sana在推理时能够更快地生成高质量图像。

4. 性能评估与实验结果

Sana在多个评测指标上表现优异,特别是在生成速度、计算效率以及图像质量上:

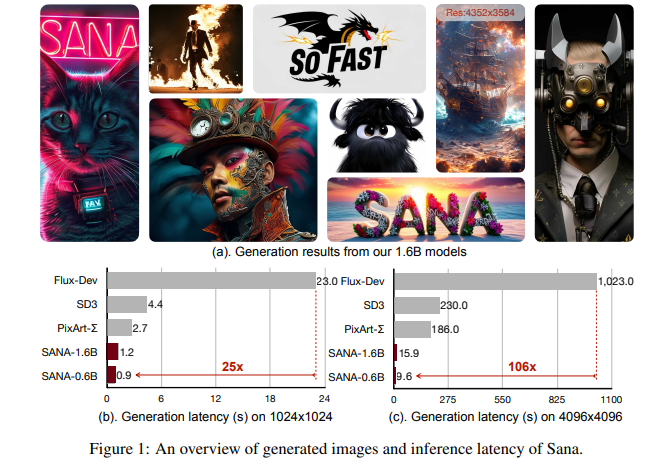

- 与现有模型的对比:与Flux、SD3、PixArt-Σ等最先进的扩散模型相比,Sana在生成速度上实现了100倍的加速,且在图像质量上保持了竞争力。特别是在1K和4K分辨率下,Sana在实际应用中的生成速度显著优于同类模型。

- 多尺度的图像生成:Sana能够生成从1024×1024到4096×4096分辨率的图像,并且在高分辨率图像生成任务中,Sana的延迟比当前最先进的模型减少了106倍。

- 小型模型部署:Sana-0.6B模型可以在16GB的消费级GPU上部署,且生成1024×1024分辨率图像的时间不到1秒,展示了其在低成本设备上的强大性能。

5. 未来发展方向

论文的结论部分提出了Sana未来的几个潜在发展方向:

- 视频生成:Sana未来可能会进一步扩展至视频生成领域,以应对日益增长的高分辨率视频生成需求。

- 生成安全性与可控性:尽管Sana在性能上表现优异,但在生成图像的安全性和可控性方面仍有待改进,特别是在生成复杂内容(如面部和手部)时,存在一定的挑战。

SANA:https://nvlabs.github.io/Sana/