经典论文Deep Residual Learning for Image Recognition是计算机视觉领域具有里程碑意义的工作之一。它引入了一种全新的神经网络结构——残差网络(ResNet),解决了深层神经网络中普遍存在的退化问题,极大地提高了深度网络的训练效果和泛化性能。其核心创新在于残差块和捷径连接的引入,使得深度网络可以更轻松地优化,并有效应对梯度消失问题。通过详细的实验验证,作者展示了残差网络在ImageNet等大规模数据集上的优越性能,推动了深度学习在计算机视觉领域的进一步发展。这一创新性工作不仅为深度神经网络的设计提供了新的思路,也为后续的各种深度学习模型和技术奠定了基础。此论文的研究成果被后续研究大量引用。

论文作者为Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun(何恺明、张翔宇、任少卿和孙剑),来自Microsoft Research(微软研究院)。

以下为论文内容介绍:

1. 背景与挑战

近年来,深度卷积神经网络(Convolutional Neural Networks, CNNs)在图像分类、目标检测等领域取得了巨大成功,例如AlexNet、VGG等模型都展示了深度学习在视觉任务中的强大表现。然而,随着神经网络的深度不断增加,研究人员发现,网络的性能并没有随深度的增加而一直提高,反而可能出现“退化问题”(degradation problem)。这种退化表现为:在网络深度增加时,训练误差和测试误差不降反升。这一现象与梯度消失或梯度爆炸不同,甚至在批归一化(Batch Normalization, BN)技术的帮助下,梯度的前向传播和反向传播都可以保持健康,但模型依然无法有效收敛。

深度网络中的退化现象表明,现有优化算法在面对更深的网络时,无法找到一个较好的解,这使得增加网络深度成为一个重大挑战。

2. 残差学习的核心思想

为了应对上述挑战,作者提出了残差学习框架(Residual Learning Framework),其核心思想是通过学习“残差映射”(Residual Mapping)而非直接学习复杂的映射,从而降低深层网络的学习难度。

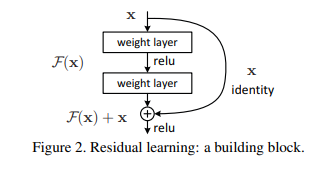

- 目标映射与残差映射:假设我们有一个输入 x,目标是学得一个映射 H(x)。在传统网络中,我们希望堆叠的网络层直接学习到这个映射 H(x)。但在残差网络中,作者提出改为学习一个残差函数 F(x)=H(x)−x,这样原本的映射就可以被表示为 H(x)=F(x)+x。通过这种重构,网络只需要学习如何调整输入以得到目标输出,这比直接学习复杂的非线性映射更容易优化。

- 捷径连接(Shortcut Connections):在残差学习中,捷径连接(也称为跳跃连接,skip connections)是至关重要的结构,它使得输入直接绕过若干层到达输出。具体来说,残差块通过捷径连接将输入直接添加到后续几层的输出中,形式为:y=F(x,{Wi})+x,其中,F(x,{Wi})表示几层卷积、批归一化和激活的组合,x 通过捷径连接直接加入到输出中,这样的结构使得信息流能够直接从输入传递到输出,即使中间的层学得不够好,输入信息也不会丢失。

3. 残差块与网络架构

论文中详细描述了残差块(Residual Block)的设计及其在深度网络中的应用。

- 残差块的设计:每个残差块包含两层卷积操作,每一层后面都跟有批归一化(Batch Normalization)和ReLU激活函数。输入通过捷径连接直接加到最后一层的输出上。在这种设计中,捷径连接是身份映射(identity mapping),这意味着它不会引入任何额外的参数或计算复杂度。

- 残差网络的架构:作者在ImageNet数据集上测试了不同深度的残差网络,从18层到152层。与传统的VGG网络相比,残差网络具有更深的层次(最多152层),但参数量和计算复杂度却相对较低。这些网络的主要结构包括一个7×7卷积层作为初始卷积层,后续为一系列的残差块,最后是全局平均池化和全连接层输出分类结果。

- 瓶颈设计(Bottleneck Design):在更深的网络(如50层、101层和152层)中,作者引入了瓶颈设计来减少计算开销。瓶颈块包含三层卷积:1×1卷积用于降维,3×3卷积用于特征提取,再通过1×1卷积恢复维度。这种设计极大地减少了参数量,同时保留了深层网络的非线性能力。

4. 实验与结果分析

作者通过一系列实验验证了残差网络在深度增加时的优越性能,主要包括ImageNet和CIFAR-10两个数据集的实验。

- ImageNet数据集:

- 作者在ImageNet 2012分类任务上使用了多种深度的残差网络,并与普通网络进行对比。结果表明,随着网络深度从18层增加到152层,残差网络的错误率持续降低。在测试集上的Top-5错误率为3.57%,显著优于之前的网络模型,如VGG和GoogLeNet。

- 在深度为34层时,残差网络与普通网络相比,具有显著更低的训练误差和测试误差,证明了残差学习能够有效应对深层网络的退化问题。

- CIFAR-10数据集:

- 在CIFAR-10数据集上,作者构建了从20层到110层的残差网络,并进一步探索了1202层的超深网络。结果表明,残差网络能够有效收敛,并且随着深度的增加,网络的性能不断提升。

- 值得注意的是,尽管1202层的网络在训练误差上几乎为零,但在测试集上的误差略高于110层的网络,这表明网络过深可能导致一定程度的过拟合。因此,作者建议在某些小型数据集上,过深的网络可能需要结合更强的正则化手段。

- 其他视觉任务:

- 作者还在COCO和PASCAL VOC等数据集上验证了残差网络在目标检测任务中的有效性。在这些任务中,残差网络通过更好的特征表示,显著提升了目标检测和定位的精度。例如,在COCO数据集上,使用ResNet-101的目标检测模型在mAP(Mean Average Precision)指标上相对于VGG-16提高了28%的相对增益。

5. 优势与性能提升的原因分析

- 优化的简化:残差学习的一个关键优势是,它将原本复杂的非线性映射分解为对输入的细微调整,这使得网络更容易进行优化。特别是当理想映射接近于身份映射时,残差块只需将其输出尽量靠近零,从而使得训练更为简单。

- 梯度的有效传播:捷径连接使得前向和反向传播时,梯度可以绕过中间层直接流向前后层,这极大地缓解了深度网络中常见的梯度消失问题,使得深层网络也能高效训练。

- 参数效率与计算复杂度:残差网络在深度增加的同时,并未显著增加参数量和计算复杂度。通过引入瓶颈设计,残差网络在保持高效非线性特征表达的同时,显著减少了计算量。例如,ResNet-152的计算复杂度低于VGG-19,但在分类任务上的表现更好。

6. 残差学习的影响与应用

残差网络的引入为深度学习特别是计算机视觉领域带来了深远影响。它的提出不仅解决了深度网络的优化难题,还为后续的网络设计提供了一个新的方向和灵感。其后的许多工作,包括DenseNet、ResNeXt等,都是在残差学习的基础上进一步改进和扩展的。

- 应用领域:残差网络被广泛应用于各种视觉任务中,包括图像分类、目标检测、语义分割等。在工业界,ResNet已成为众多计算机视觉应用的基石,尤其是在大规模图像识别和视频分析任务中,它的性能和稳定性使其成为首选模型。

- 泛化能力:残差学习的思想并不仅限于计算机视觉领域,在自然语言处理、语音识别等其他领域也有应用。其核心思想是将深度模型的学习任务分解为相对简单的残差映射,这种方法可以有效应对深层结构中的优化困难,使得更复杂的任务能够通过较深的网络来处理。