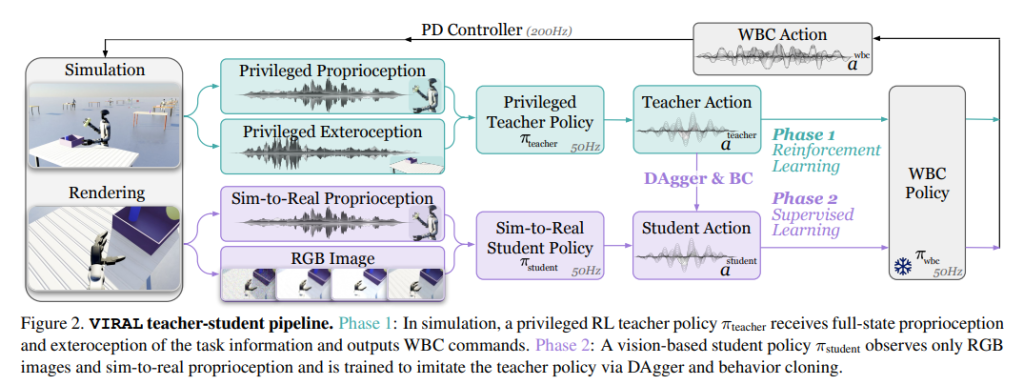

VIRAL:实现完全在仿真中学会类人机器人移动操作技能,并且无需真实世界微调就能直接部署到真机(零样本 sim-to-real)

论文 VIRAL: Visual Sim-to-Real at Scale for Humanoid Loco...

Read More静默数据损坏(Silent Data Corruption, SDC)

论文Understanding Silent Data Corruption in LLM Training研...

Read MoreURANIA:严格差分隐私(Differential Privacy, DP)约束下,对海量 LLM 聊天记录做“用例洞察/主题总结”的框架

论文Urania: Differentially Private Insights into AI Use提出...

Read MoreClio(Claude insights and observations):让AI助手把数百万对话归纳成可探索的聚合洞察

论文Clio: Privacy-Preserving Insights into Real-World AI...

Read More