比尔·盖茨谈气候变化、能源、全球健康和教育,以及人工智能如何帮助改变这些领域

近日,里德(Reid Hoffman)和阿里亚与比尔·盖茨一起讨论了他主要关注的领域:气候变化、能源、全球健康...

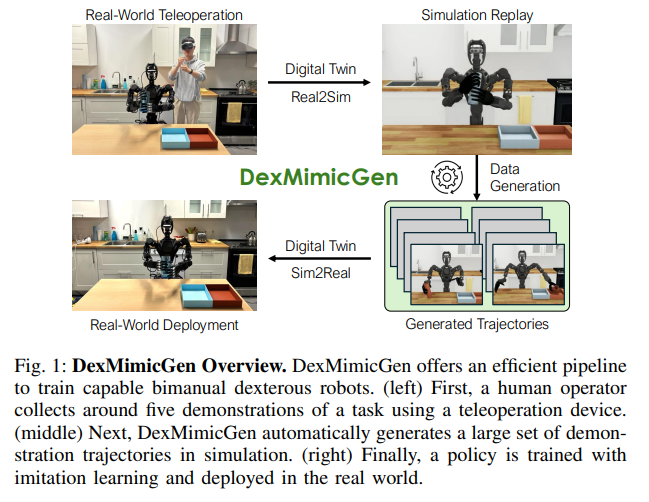

Read MoreDexMimicGen:通过模仿学习实现双手灵巧操作的数据自动生成

论文DexMimicGen: Automated Data Generation for Bimanual D...

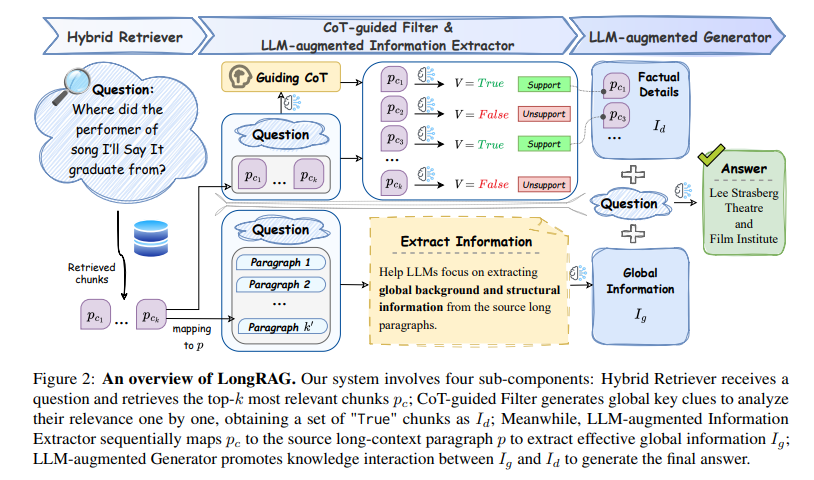

Read MoreLongRAG:有效地解决了长文本(Long-Context,长上下文)场景中“丢失中间信息”和“事实细节识别难”问题

论文LongRAG: A Dual-Perspective Retrieval-Augmented Gener...

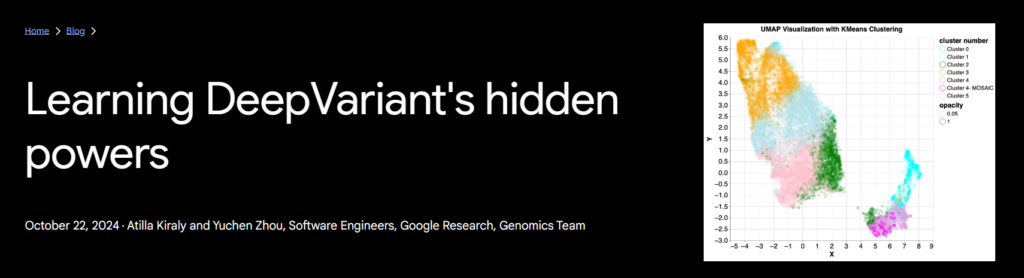

Read More深度探究DeepVariant模型(基因变异检测模型)内部的特征嵌入和高维特征,揭示其内在工作机制

DeepVariant是由Google研究团队开发的一种基因变异检测工具,主要用于检测基因组测序数据中的小变异...

Read More