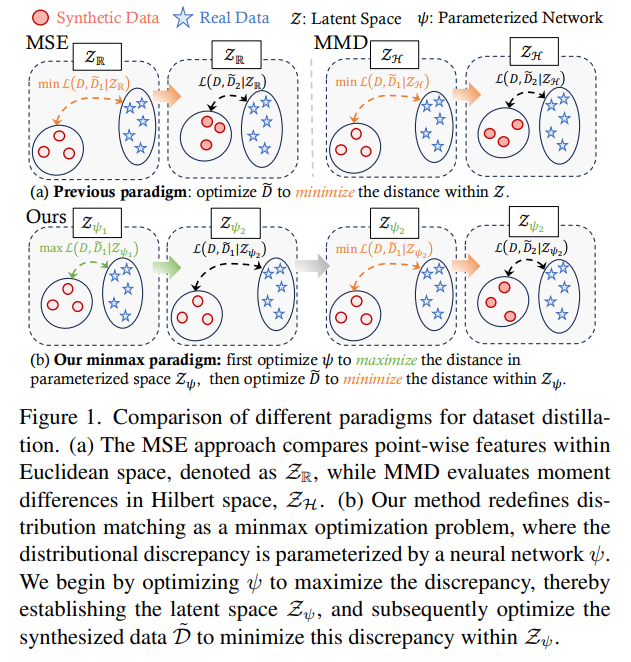

基于神经特征函数匹配(Neural Characteristic Function Matching, NCFM)方法的数据集蒸馏:GPU 内存使用量减少300倍以上,处理速度提升20倍

深度神经网络(DNN)在各种任务上取得了巨大成功,其中一个关键因素是大规模训练数据的可用性。然而,在存储受限的...

Read MoreOpenAI GPT-4.5 系统说明(OpenAI GPT-4.5 System Card)

一、引言GPT-4.5 是 OpenAI 迄今为止最大、最具知识性的 AI 模型,其目标是相较于前代模型(如...

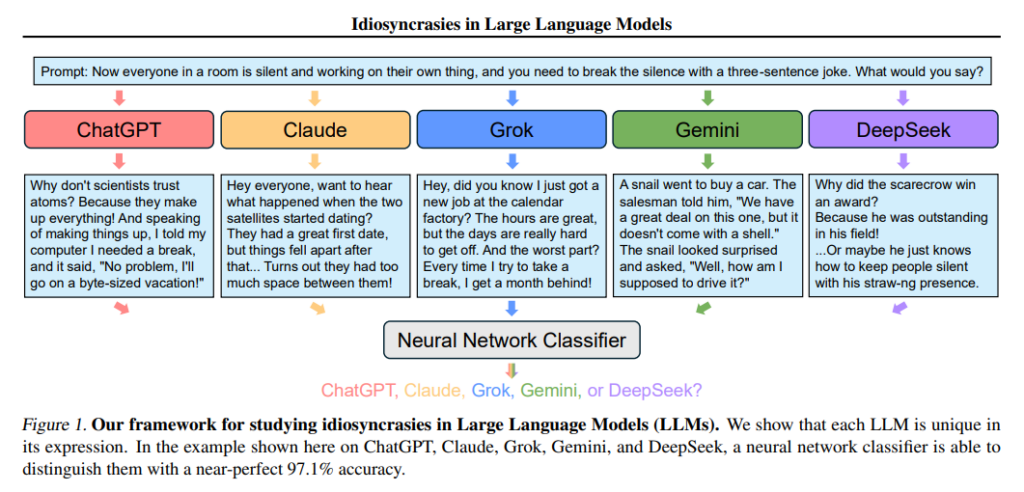

Read More不同大模型有其特有的AI味儿—大模型的“癖好”或特质(idiosyncrasy)

ChatGPT的输出文本中,中文常出现“旨在”,英文“Delve”一词有较高的出现频率,这是其特有的AI味儿。...

Read More在JEPA (Joint Embedding Predictive Architecture,联合嵌入预测架构)模型的潜在空间中进行规划,可在新环境布局泛化、轨迹拼接和数据效率方面获得良好效果

论文Learning from Reward-Free Offline Data: A Case for Pl...

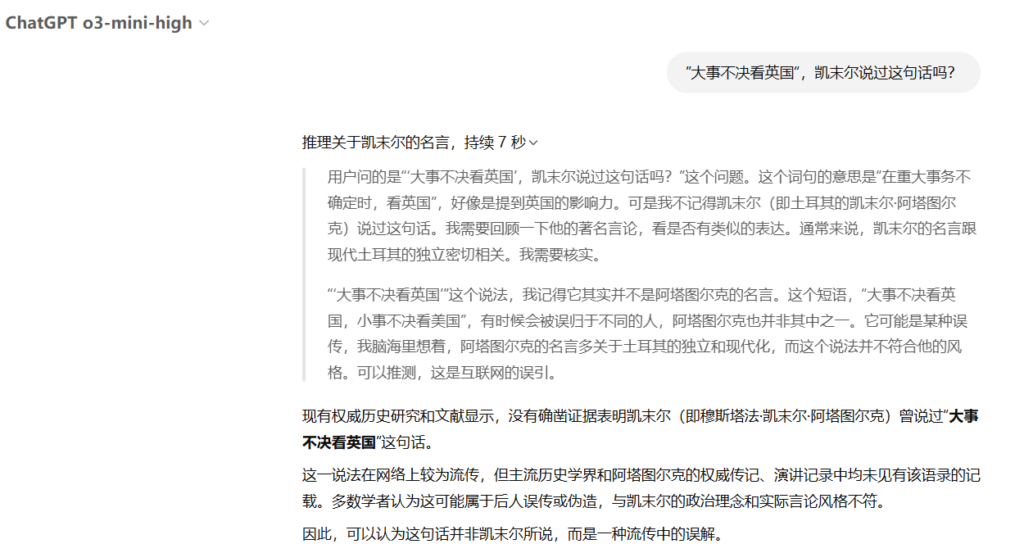

Read More用ChatGPT o3-mini-high分析Deepseek刚开源的FlashMLA

用ChatGPT o3-mini-high分析Deepseek刚开源的FlashMLA。上传FlashMLA工...

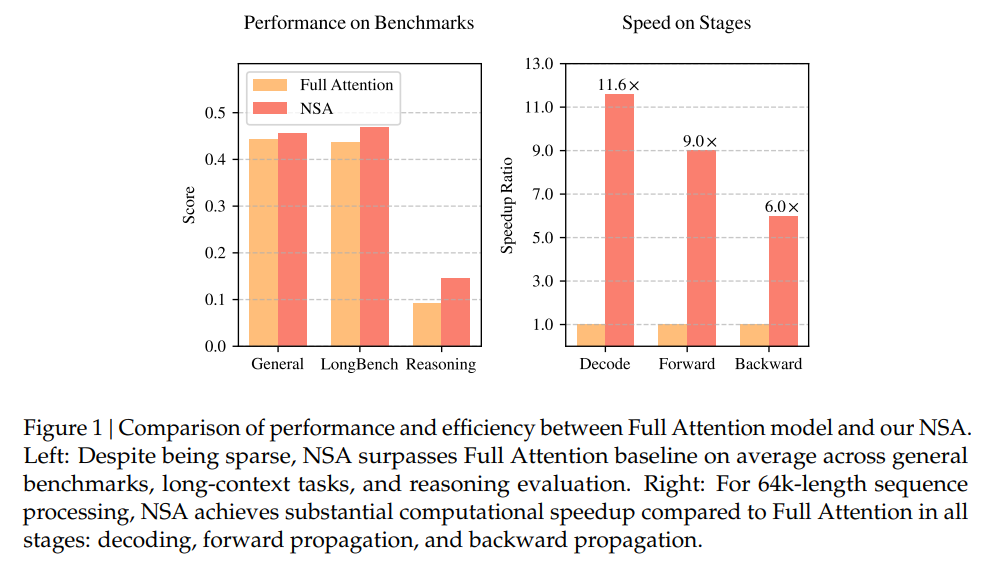

Read MoreNSA(Native Sparse Attention)机制:原生可训练的稀疏注意力架构,通过硬件对齐优化和算法创新实现高效长序列建模

论文Native Sparse Attention: Hardware-Aligned and Nativel...

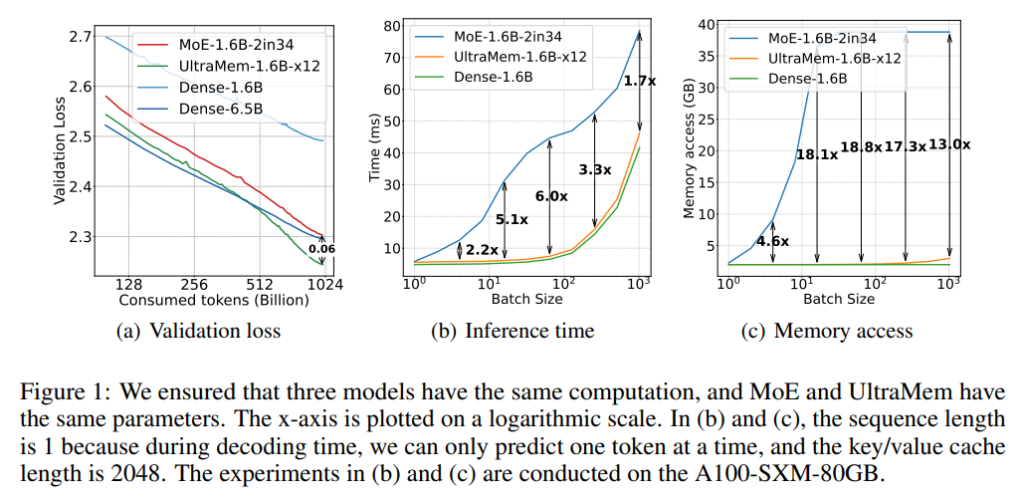

Read MoreUltraMem:利用大规模的超稀疏内存层(Ultra-Sparse Memory Layer)显著提升Transformer模型性能

论文Ultra-Sparse Memory Network提出了一种名为UltraMem的新型神经网络架构,解...

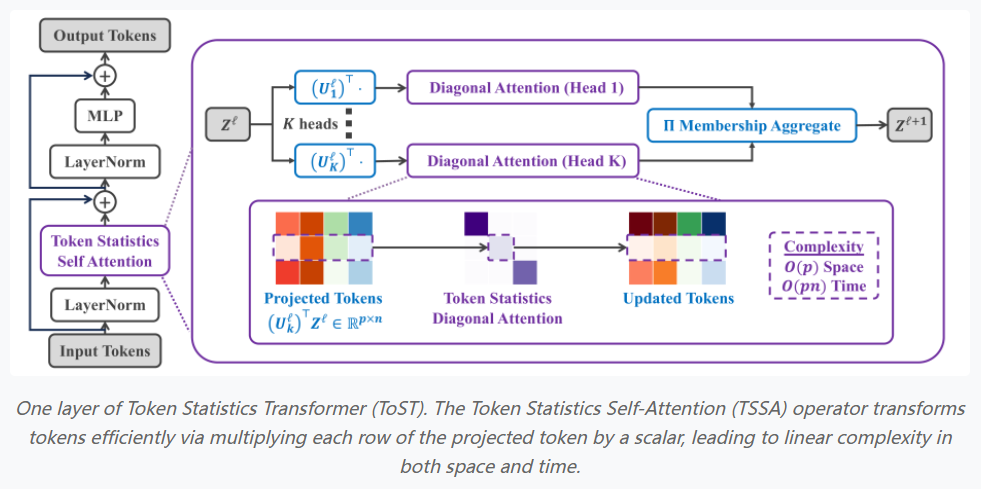

Read MoreToken Statistics Transformer:通过引入TSSA(Token Statistics Self-Attention)注意力模块,显著降低Transformer的计算复杂度和内存需求

论文Token Statistics Transformer: Linear-Time Attention v...

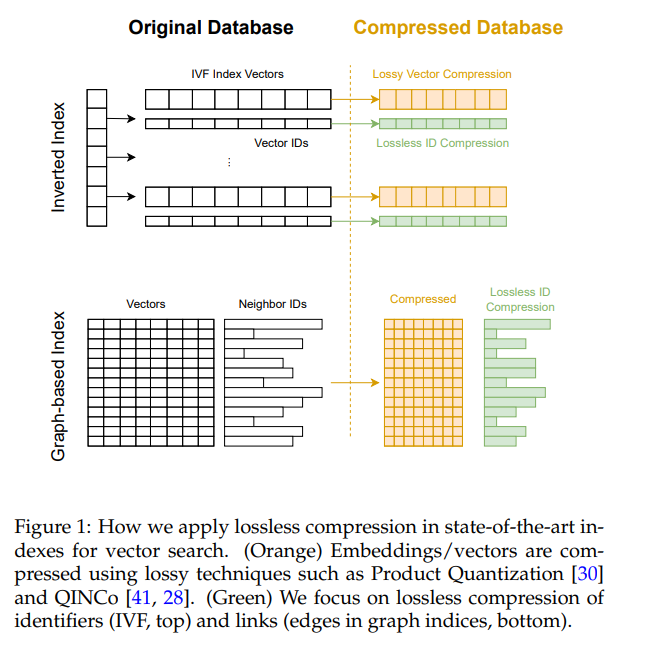

Read More采用非对称数字系统(ANS)和波列树(Wavelet Trees)的无损压缩方法,对近似最近邻搜索(ANNS)中的向量ID和图结构进行优化

论文Lossless Compression of Vector IDs for Approximate Ne...

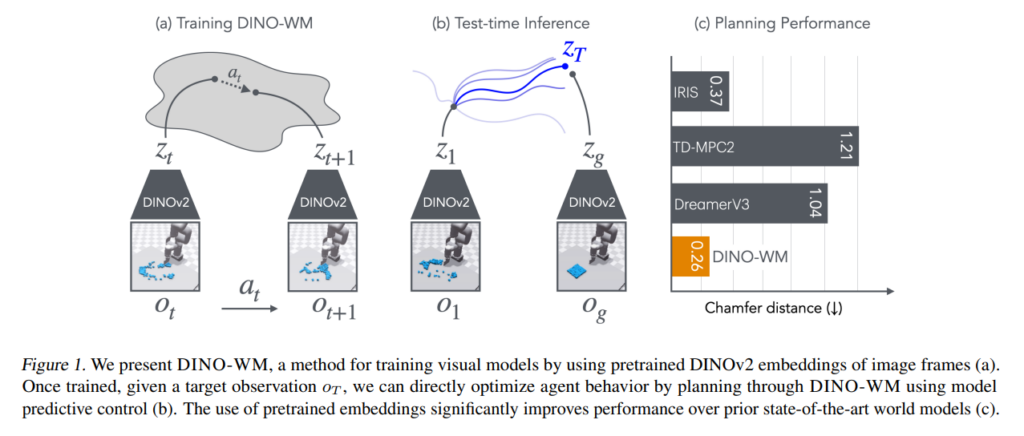

Read MoreDINO-WM:基于预训练视觉特征,可实现零样本(Zeor-shot)规划的世界模型(World Model )

近年来,机器人技术和具身人工智能(Embodied AI)领域取得了显著进展,特别是在模仿学习(Imitati...

Read More生成式AI(Generative AI,GenAI)导致人类批判性思维(Critical Thinking)能力下降?

论文The Impact of Generative AI on Critical Thinking: Sel...

Read More