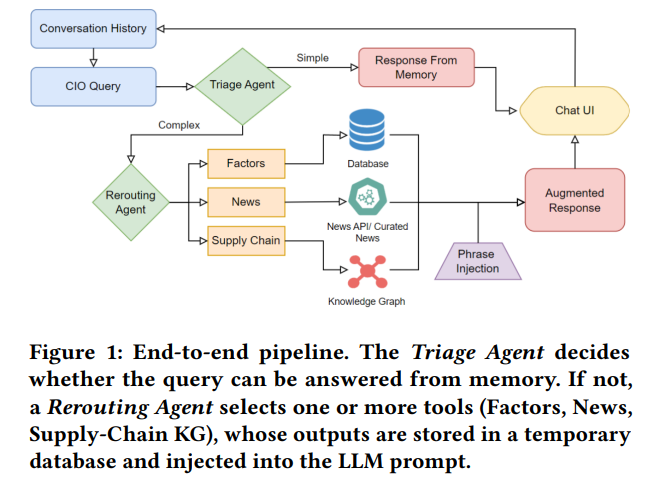

创新的供应链风险分析:先用知识图谱检索,再把检索到的“经济上最有意义”的子图喂给LLM/RAG

论文Exploring Network-Knowledge Graph Duality: A Case Stu...

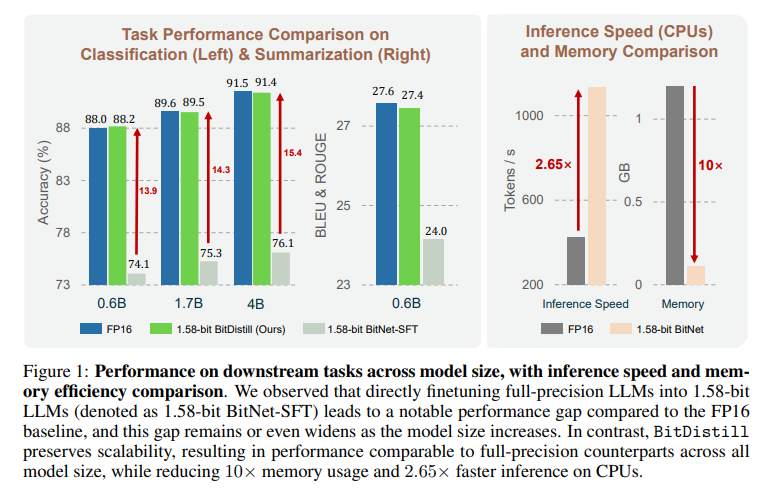

Read MoreBitDistill:LLM权重从FP16量化到1.58-bit,精度基本无损,内存消耗下降显著,推理速度提升

论文BitNet Distillation提出 BitNet Distillation(BitDistill)...

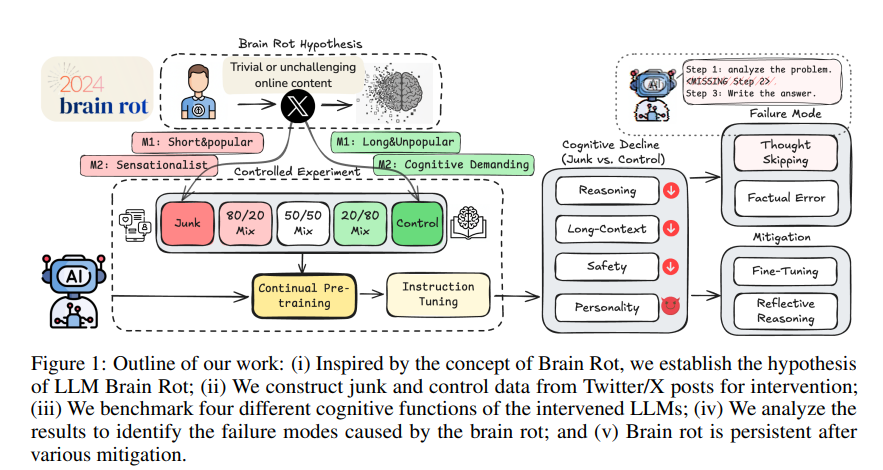

Read MoreLLM 脑腐化(Brain Rot):碎片化、吸睛但低信息的内容会在持续预训练中“腐蚀”模型的思考链条与长程记忆,且很难被事后微调完全补救

论文LLMs Can Get “Brain Rot”!提出并实证验证“LLM 脑腐化(...

Read MoreAB-UPT(Anchored-Branched Universal Physics Transformer):具备较高准确性和效率的CFD建模替代

经典CFD(Computational Fluid Dynamics)仿真在汽车与航空航天外流场分析中耗时高、...

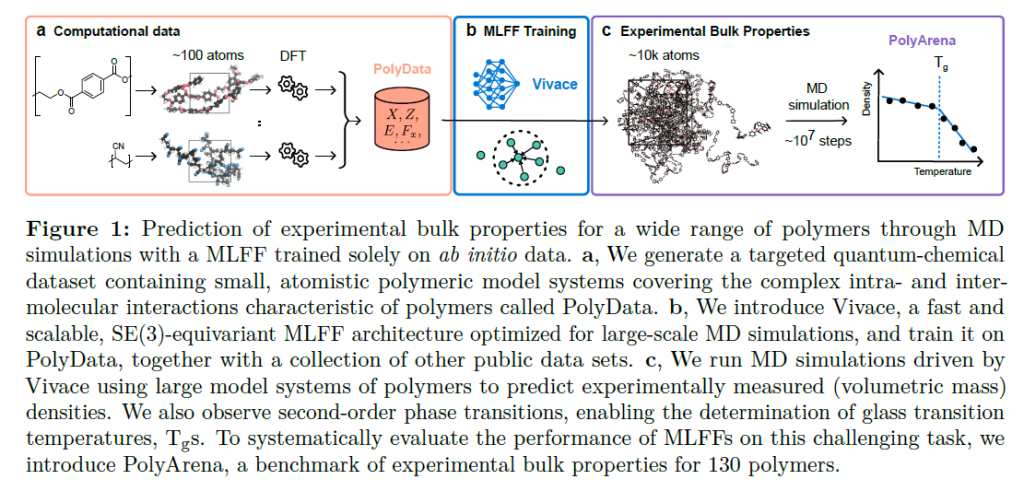

Read MoreSimPoly:通过基于第一性原理的机器学习力场(MLFF)方法进行聚合物模拟仿真

聚合物具有多尺度、强相互作用耦合等复杂性,传统经典力场(如 PCFF/OPLS)在可迁移性与精度上常受限,而从...

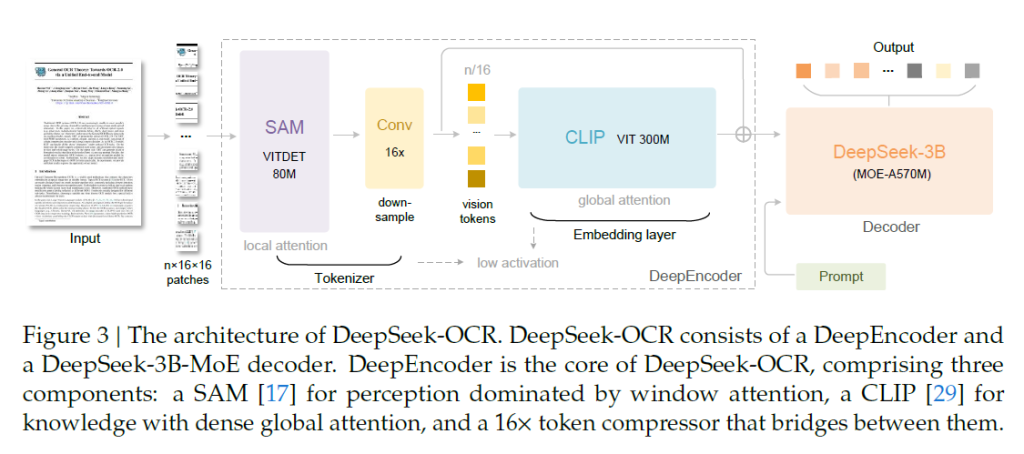

Read MoreDeepSeek-OCR:不是“一目十行”,而是“百行”乃至“千行”的上下文理解

当今大模型在处理长文本时,注意力计算随长度二次增长,算力与显存压力巨大。DeepSeek的最新模型DeepSe...

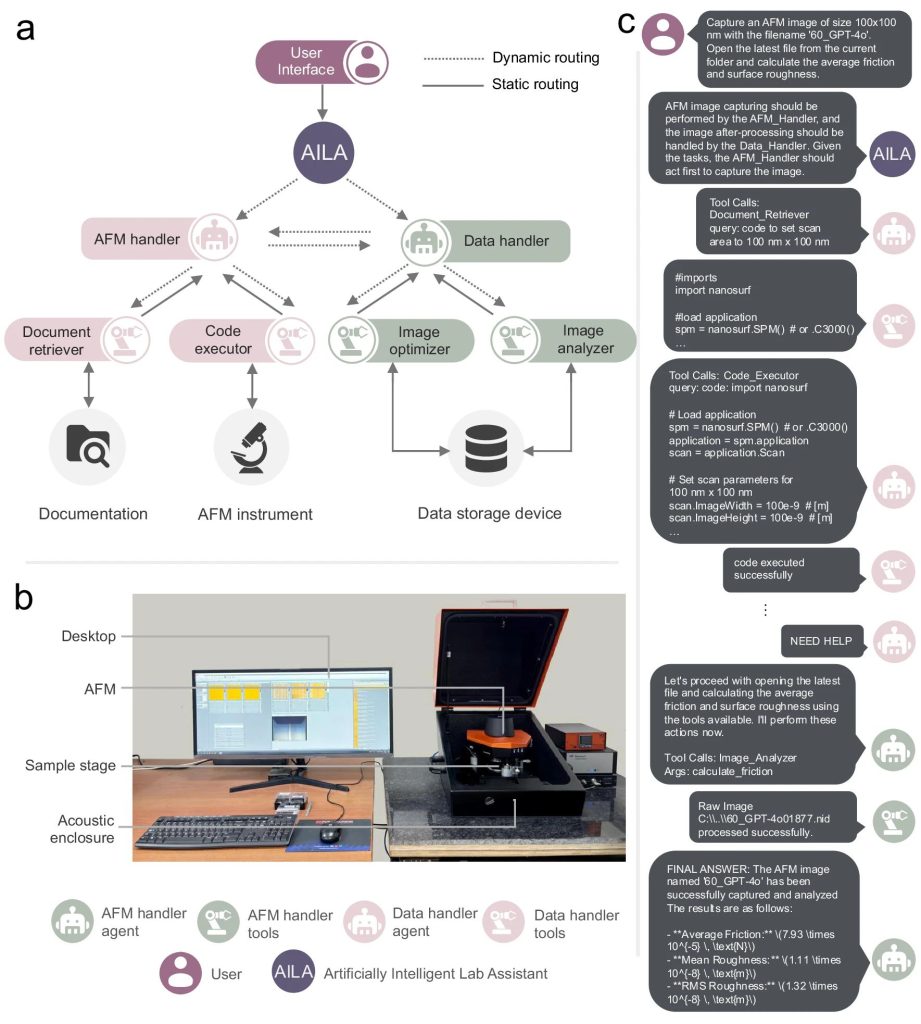

Read More用于自驱动实验室(self-driving laboratories, SDL)的AI智能体

大型语言模型(LLM)正被用于构建“自驱动实验室(self-driving laboratories, SDL...

Read MoreChatGPT的新建聊天中,能否指定一个或多个历史聊天记录作为本次对话的context?其实这是一个硬需求

短答:不能在“普通新建聊天”里直接指定某几段“历史对话”作为上下文自动载入。 但有几种官方支持的替代方案,能实...

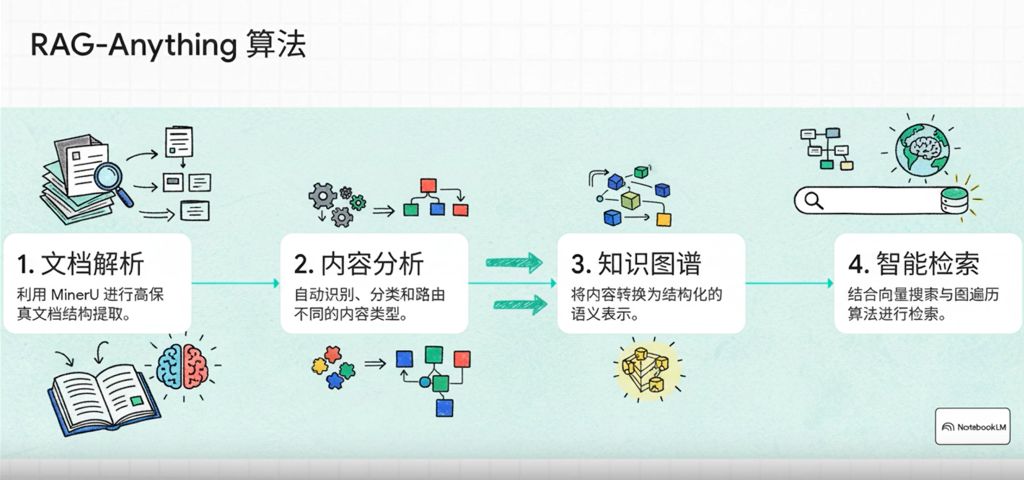

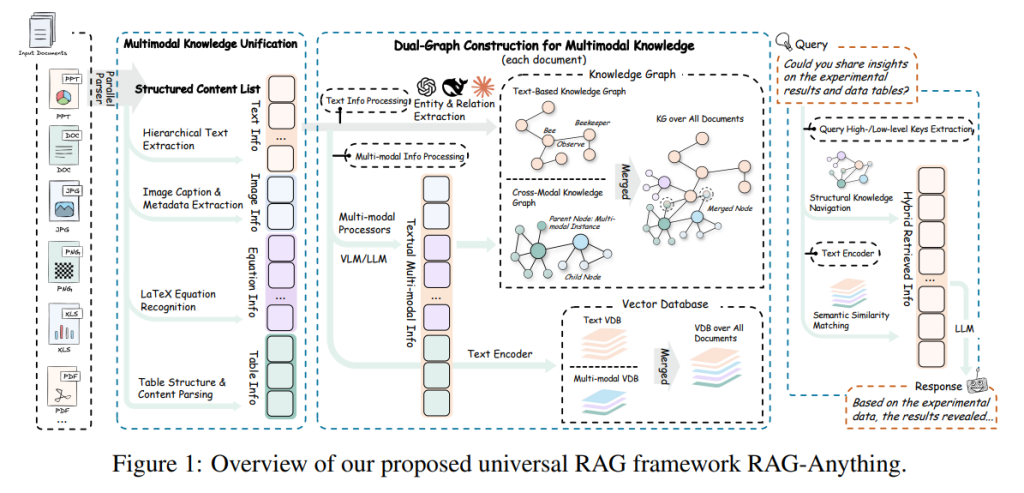

Read More整合MinerU + Chonkie + RAG-Anything 的 RAG系统技术实现

今日略研究了一下整合MinerU + Chonkie + RAG-Anything 的 RAG系统技术实现:...

Read More自对数演化解码(Self Logits Evolution Decoding, SLED):修正模型“知道的”(潜在知识)与“说出来的”(最终层logits经softmax得到的输出分布)之间的偏差

大型语言模型(LLM)在多任务上表现强劲,但“编造/幻觉”导致事实性不足,限制了实际可信度。论文SLED: S...

Read More